Itzulpen automatiko neuronal

Itzulpen automatiko neuronala (ingelesez: Neural Machine Translation, NMT) itzulpen automatikoa lantzeko planteamendu bat da. Neurona-sare handiak erabiltzen ditu hitz-sekuentzia batek duen agertzeko probabilitatea aurreikusteko, eta normalean esaldi osoak ere modelatzen ditu eredu integratu bakar batean.

Itzulpen automatiko neuronal sakona aurrekoaren hedadura bat da. Biek erabiltzen dute neurona-sare handi bat baina itzulpen automatiko neuronal sakonak hainbat geruza prozesatzen ditu batera bakarka egin ordez.[1]

Alor honetan izan den garapena ikaragarri azkarra izan da. Ikaskuntza sakona (deep learning) teknika Itzulpengintza automatikoan erabili zuen lehenengo argitalpen zientifikoa 2014ean agertu zen, egileak Bahdanau, Cho eta Bengio izan ziren. 2015ean lehenengo aldiz agertu zen neurona-sistema bat itzulpen automatikozko txapelketa batean (OpenMT’15). Eta hurrengo urtean txapeldunen %90a sistema neuronalak izan ziren. 2015eko aurrerapena arretan oinarritutako sistemak ("attenttion based NMT") erabiltzea izan zen. 2017an hobekuntza gehigarriak lortu ziren neurona-sareetan Transformer arkitektura erabiltzearen ondorioz. Urte bat geroago euskara ere arrakastaz erabiltzen zuen sistema bat zegoen, eta beste urte batean, 2019an, euskararako zeuden sistemak bost ziren.

Ezaugarriak

Itzulpen automatiko estatistikoko ereduek behar duten memoria baino askoz txikiagoa izaten da neurona-itzultzaileen kasuan behar dena. Gainera, betiko itzulpen-sistemetan ez bezala, atal guztiak denak batera entrenatuta lortzen dira itzulpen-ereduak, itzulpenaren emaitzetan hobekutzak maximizatzeko.[2][3][4]

Historia

Ikasketa sakoneko lehenengo aplikazioak hizketa-ezagutza automatikoko sistemetan agertu ziren 1990eko hamarkadan. Itzulpen automatikoan teknika hau erabili zuen lehenengo argitalpen zientifikoa 2014ean agertu zen,[5] eta hurrengo urteetan aurrerapauso handiak egin ziren (bokabulario handiko NMTa, irudien azalpenei aplikatzea, hitza baino unitate txikiagotan oinarritutako NMTa, NMT eleaniza, iturri anitzeko NMTa, karakterekako NMTa, baliabiderik gabeko NMTa, Google, karakterekako-NMT erabatekoa, Zero-Shot NMTa 2017an). 2015ean lehenengo aldiz agertu zen NMT sistema bat itzulpen automatikozko txapelketa batean (OpenMT’15). Urte berean WMT’15 txapelketan ere sartu zen NMT sistema bat eta hurrengo urtean txapeldunen %90a NMT sistemak izan ziren.[6]

Funtzionamendua

Itzulpen automatiko neuronalaren abiapuntua azpiesalditan oinarritutako sistema estatistikoak izan ziren, non azpi-osagaiak bakoitza bere aldetik sortzen den, era independentean. Alde horretatik NMTa ez da izugarrizko aurrerapausoa, itzulpen automatiko estatistikoetako antolaketa normalean horrela ere egiten baitzen.[7] Neuronen bidezko hurbilpenaren aurrerapauso nagusia hitzak eta barne egoerak bektore-bidez errepresentatzea izan da ("embedding-ak", "etengabeko espazioko errepresentazioak"). Eredu horien egitura, azpi-esalditan oinarritutako eredu estatistikoen egitura baino sinpleagoa da. Hizkuntza-eredua, itzulpen-eredua eta berrordenatze-eredua ez dira azaltzen hiru eredu independente moduan, sekuentzia-eredu bakar bat baitago, aldi bakoitzean hitz bat iragartzen duena. Hala ere, hitzen iragarpen hori egiten denean iturburu-esaldi osoa kontuan hartzen da, baita jadanik ekoiztuta dagoen helburu-sekuentziaren zatia ere.[8]

NMT-ereduek ikasketa sakoneko eta errepresentazio-ikasketako kontzeptuak erabiltzen dituzte.

Hasieran, hitz-sekuentzien eredua Neurona-sare errekurrenteak (ingelesez: Recurrent Neural Network, RNN) baliatuta lortzen zen. Neurona-sareak neurona-sare errekurrente bidirekzional bat (kodetzailea) erabiltzen du iturburu-esaldi bat kodetzeko eta bigarren neurona-sare errekurrente bati pasatzeko, azken horrek gero helburu-hizkuntzako hitzak iragar ditzan.[9]

Printzipioz, Neurona-Sare Konboluzionalak (ingelesez: Convolutional Neural Networks, Convnet) hobeak dira sekuentzia luze jarraietarako, baina hasiera batean ez ziren erabiltzen ahuleziak zituztela-eta; hala ere, 2017an ahulezia horiek konpentsatu egin ziren arretan oinarritutako hurbilketak erabiliz.[9][10][11]

2017an hobekuntza gehigarriak lortu ziren neurona sareetan Transformer arkitektura erabiltzaren ondorioz.[12]

Erabileraren bilakaera

2016an MT sistema hoberenak neurona-sareak erabiltzen ari ziren. Google, Microsoft eta Yandex-en[13] itzulpen zerbitzuek NMT erabiltzen dute orain. Google-k Google Neural Machine Translation izeneko sistema erabiltzen du orain, lehen erabiltzen zuen metodo estatistikoetan oinarritutakoaren ordez.[14] Microsoft-ek antzeko teknologia erabiltzen du mintzamen-itzulpenetarako (horien artean Microsoft Translator Live eta Skype Translator aplikazioetan).[15] Hardvard NLP taldeak OpenNMT izena duen kode irekizko neurona-sare sistema bat argitaratu du.[16] Yandex itzultzaileak eredu hibrido bat dauka: haren itzulpenak modelo estatistiko bat eta neurona-sare bat ematen ditu; ondoren, CatBoost algoritmoak (ikasketa sakonean oinarritutakoa) lortutako emaitza onena aukeratuko du. Itzulpen automatikozko hornitzaileek neurona-sareen bidezko sistemak ere eskaintzen hasi dira, besteak beste hauek: Omniscien Technologies (lehen Asia Online)[17], Tilde[18], KantanMT[19], SDL[20], Globalese[21], TransPerfect eta Ixa Taldea. DeepL-ek itzulpen-sistema generiko bat eskaintzen du ikasketa sakoneko adimen artifizialezko sistemekin. Aldiz, Omniscien Technologies-ek Itzulpen automatiko neuronal sakona duten sistema pertsonalizatuak eskaintzen ditu (Deep NMT) eta Systrans-ek itzulpen automatiko neuronala ere eskaintzen du, neurona-sare sakonekin. Ixa Taldeak NMT demo bat eskaintzen du euskara eta espainiera hizkuntzen artean.[22] VicomTech eta Elhuyar fundazioarekin ikertzen ari da teknologia berri honetan.[23]

Euskararako itzultzaile neuronalak

Paradigma neuronalaren ekarriarekin 2017z geroztik izugarrizko hobekuntza nabaritu zen hizkuntza nagusienen arteko itzultzaile automatikoetan. Geroxeago, eta arin, euskal munduko ikerkuntza komunitatea gai izan zen euskaratik eta euskararako itzultzaile neuronalak mundu mailako artearen egoeraren pare jartzeko.

2015ean hasi zen euskararako itzulpen neuronala aztertzen TADEEP proiektuan.[24] Ordurako Deepl itzultzaileak kalitatezko emaitzak ematen zituen 10 hizkuntzatan baina euskara ez zegoen horien artean.[25] Bi urte geroago lehenengo emaitza bikainak lortuta, 2017an lehen demoa publikoki eskura zegoen. 2017an bertan, hainbat agente (Ixa Taldea, Elhuyar, Vicomtech, Ametzagaña, Mondragon Lingua...) batera, MODELA izeneko proiektua abiatu zen.[25][26] Beste urtebeteko epean, 2018an MODELA itzultzailea plazaratu zen, Interneten publiko orokorrerako euskarazko itzulpen neuronala eskaintzen zuen lehen zerbitzua.

Abiada bizian mugitzen zen arlo honetan, geroago gutxienez beste lau itzultzaile neuronal gehiago plazaratu ziren. Horien arteko diferentzia nagusia itzultzaile bakoitzak erabiltzen duen corpusa da (corpus = milioika esaldi bi hizkuntzatan), baita itzultzeko zerbitzuan onartzen duten hitz-kopuru maximoa ere (konputagailu ahaltsu eta garestiak erabili behar dira horretan). Hauek ziren 2020ko hasieran eskaintzen ziren euskararako itzultzaile neuronalak:

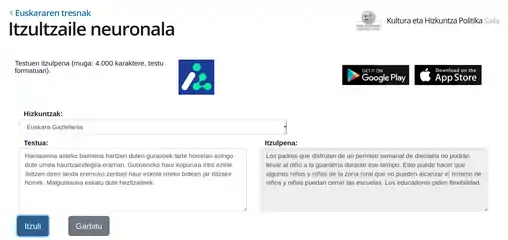

- Eusko Jaurlaritzaren Itzultzaile neuronala: itzulpen neuronalaren teknologia erabilita, corpus-oinarria Eusko Jaurlaritzako itzulpen-memoriak erabili ziren IVAP-HAEEk 20 urtetan bildutakoa 10 milioi "esaldi" baino gehiago..[27]

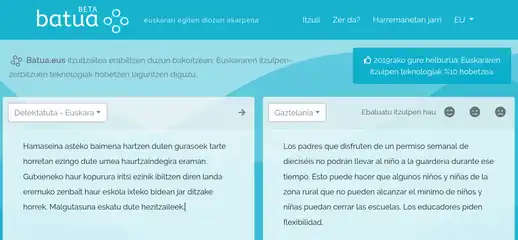

- batua.eus: Vicomtech-ek MODELA sisteman hobekuntzak egin zituzten (RNN teknologiatik Transformer teknologiara pasa ziren) eta corpusa handitu zuten.[28][12]

- elia.eus: Elhuyarrek ere antzeko hobekuntzak egin zituen bere aldetik. Eta itzulpenak egiteko hizkuntza berriak gehitu zituen (ingelesa, frantsesa, espainiera, galegoa, eta katalana)[29]

- lingua.eus: ofrecido por MondragonLingua.[30]

- Translate Google: Googleren Translate zerbitzuak hobekuntzak lortu zituen eredu neuronala erabilita.[31]

Jaurlaritzaren itzutzaile neuronala

Jaurlaritzaren itzutzaile neuronala Batua.eus

Batua.eus

Erreferentziak

- (Ingelesez) «Deep Neural Machine Translation - Omniscien Technologies» Omniscien Technologies (Noiz kontsultatua: 2018-02-27).

- Sutskever, Ilya; Vinyals, Oriol; Le, Quoc V.. (2014-09-10). «Sequence to Sequence Learning with Neural Networks» arXiv:1409.3215 [cs] (Noiz kontsultatua: 2018-03-01).

- Kalchbrenner, Nal; Blunsom, Philip (2013). "Recurrent Continuous Translation Models". Proceedings of the Association for Computational Linguistics.

- Cho, Kyunghyun; van Merrienboer, Bart; Bahdanau, Dzmitry; Bengio, Yoshua. (2014-09-03). «On the Properties of Neural Machine Translation: Encoder-Decoder Approaches» arXiv:1409.1259 [cs, stat] (Noiz kontsultatua: 2018-03-01).

- Bahdanau, Dzmitry; Cho, Kyunghyun; Bengio, Yoshua. (2016-05-19). «Neural Machine Translation by Jointly Learning to Align and Translate» arXiv:1409.0473 [cs, stat] (Noiz kontsultatua: 2020-01-28).

- Bojar, Ondrej; Chatterjee, Rajen; Federmann, Christian; Graham, Yvette; Haddow, Barry; Huck, Matthias; Yepes, Antonio Jimeno; Koehn, Philipp; Logacheva, Varvara; Monz, Christof; Negri, Matteo; Névéol, Aurélie; Neves, Mariana; Popel, Martin; Post, Matt; Rubino, Raphael; Scarton, Carolina; Specia, Lucia; Turchi, Marco; Verspoor, Karin; Zampieri, Marcos (2016). "Findings of the 2016 Conference on Machine Translation" (PDF). ACL 2016 First Conference on Machine Translation (WMT16). The Association for Computational Linguistics: 131–198.

- Wołk, Krzysztof; Marasek, Krzysztof. «Neural-based Machine Translation for Medical Text Domain. Based on European Medicines Agency Leaflet Texts» Procedia Computer Science 64: 2–9. doi:. (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «The State of Neural Machine Translation (NMT) by Philipp Koehn - Omniscien Technologies» Omniscien Technologies 2016-11-30 (Noiz kontsultatua: 2018-03-01).

- Bahdanau, Dzmitry; Cho, Kyunghyun; Bengio, Yoshua. (2014-09-01). «Neural Machine Translation by Jointly Learning to Align and Translate» arXiv:1409.0473 [cs, stat] (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) Coldewey, Devin. «DeepL schools other online translators with clever machine learning» TechCrunch (Noiz kontsultatua: 2018-03-01).

- Luong, Minh-Thang; Pham, Hieu; Manning, Christopher D.. (2015-09-20). «Effective Approaches to Attention-based Neural Machine Translation» arXiv:1508.04025 [cs] (Noiz kontsultatua: 2020-01-28).

- Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia. (2017). Guyon, I. ed. «Attention is All you Need» Advances in Neural Information Processing Systems 30 (Curran Associates, Inc.): 5998–6008. (Noiz kontsultatua: 2020-01-28).

- (Ingelesez) «Yandex — Company blog — One model is better than two. Yandex.Translate launches a hybrid machine translation system» Yandex (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) Lewis-Kraus, Gideon. (2016-12-14). «The Great A.I. Awakening» The New York Times ISSN 0362-4331. (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «Microsoft Translator launching Neural Network based translations for all its speech languages» Translator (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «OpenNMT - Open-Source Neural Machine Translation» opennmt.net (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «Omniscien Technologies Announces Release of Language Studio with Next-Generation Neural Machine Translation Technology - Omniscien Technologies» Omniscien Technologies 2017-04-21 (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «MT Features: Neural Machine Translation | tilde.com» Machine Translation (Noiz kontsultatua: 2018-03-01).

- «KantanMT - Cloud-based Machine Translation Platform» KantanMT (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «SDL Brings Neural Machine Translation to its Secure Enterprise Translation Server | SDL» SDL (Noiz kontsultatua: 2018-03-01).

- (Ingelesez) «Globalese 3.0 released - Globalese» Globalese 2017-09-05 (Noiz kontsultatua: 2018-03-01).

- «NMT demoa (euskara-espainiera) | TAdeep proiektua» Ixa Taldea (Noiz kontsultatua: 2018-05-27).

- «Mintegia: Itzulpen automatikoko proiektuak, TADEEP eta MODELA (Gorka Labaka, 2018-03-27) | Hizkuntza-teknologiak» www.unibertsitatea.net (Noiz kontsultatua: 2018-05-27).

- «Welcome to TAdeep (MINECO-FEDER project) | TAdeep» ixa2.si.ehu.es (Noiz kontsultatua: 2020-01-28).

- Alegria, Iñaki. (2018-09-11). «Itzulpen automatiko neuronalaren aurrerapenak eskura» Sarean .eus (Noiz kontsultatua: 2020-07-13).

- «MODELA» modela.ametza.com (Noiz kontsultatua: 2020-01-28).

- Eusko Jaurlaritza. (2019). «Euskara-Gaztelania itzultzaile automatiko neuronala» www.euskadi.eus (Noiz kontsultatua: 2020-01-28).

- «BATUA.eus - Euskarazko itzultzailea» www.batua.eus (Noiz kontsultatua: 2020-01-28).

- «Itzultzailea» Itzultzailea (Noiz kontsultatua: 2020-01-28).

- «MondragonLinguaren Itzultzailea - Itzultzailea» lingua.eus (Noiz kontsultatua: 2021-10-11).

- «Google Translate» translate.google.com (Noiz kontsultatua: 2020-01-28).