Informazio kantitate

Informazio-teorian, informazio kantitatea zorizko aldagai batek lagin batean eman dezakeen informazioa da. Formalki, probabilitate teorian edozein gertaerarako definitutako ausazko aldagaia da informazio kantitatea, ausazko aldagaia neurtua izango den ala ez kontuan hartu gabe. Informazio kantitatea informazio-unitateetan adierazten da.

Informazio-teoriaren testuinguruan, informazio kantitatearen itxaropen matematikoa entropia da, eta zera adierazten du: behatzaile batek sistema baten ausazko aldagai baten laginketatik lortzea espero dezaken batezbesteko informazio-kantitatea.[1]

Definizioa

ausazko aldagaia eta haren probabilitate-funtzioa izanik, aldagaiak emaitza lortzeak ematen duen informazio kantitatea horrela definitzen da:

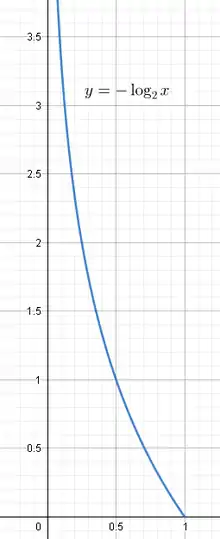

Grafikoan ikusten den bezala, gertaeraren probabilitatea baxua bada (0tik gertukoa), haren informazio ekarpena altua da; probabilitatea altua bada (1etik gertukoa), ordea, informazio-kantitate txikia ekarriko du. probabilitate bat izanik, tarteko balio bat hartuko du; 0 bada, informazio kantitatea kalkulatzeak ez dauka zentzurik, emaitza hori gertatzea ezinezkoa delako.

Logaritmo funtziorako aukeratzen den oinarriaren arabera, informazio kantitatea unitate desberdinean neurtzen da. Oinarria 2 bada, unitatea shannon ala bita da.

Propietateak

Gertaera independenteen batura

Bi gertaera independenteen informazio kantitatea gertaeren informazio kantitateen batura da. Matematikan, propietate hori batukortasuna da. Izan bitez eta ausazko bi aldagai independente eta eta haien probabilitate-funtzioak, hurrenez hurren. Gertaerak independenteak direnez, baterako probabilitate-funtzioa honakoa da:

emaitzaren informazio kantitatea honakoa da:

Adibideak

Txanpon jaurtiketa

Txanpon bat airera jaurtiz gero, aurpegia ala gurutzea ateratzeko probabilitatea ekoa eta ekoa dira, txanpona sahieska erortzea ezinezkoa dela suposatuz, noski. Beraz,

,

,

Informazio hori adierazteko bit bakar batekin nahikoa da.

Arrantzaketa

Demagun ur putzu batean 15 atun (), 13 izokin () eta 2 txitxarro () daudela eta bertan arrantzan ari den lagunak arrain bat harrapatu duela. Mota bakoitzeko arraina arrantzatzearen informazio kantitatea horrela kalkulatzen da:

,

,

,

Ikus daiteke informazio kantitate handieneko gertaera txitxarroa arrantzatzea dela; gertatuz gero, atuna edo izokina arrantzatzeak baino informazio gehiago emango du, putzuaren egoera nabarmenago aldatuko delako.

Entropiarekiko erlazioa

Entropia ausazko aldagai diskretu baten informazio-kantitatearen itxaropen matematikoa da. Batzuetan, entropia aldagaiaren “informazio kantitatea” dela esaten da, seguraski betetzen delako, izanik aldagaiak bere buruarekin partekatzen duen elkarrekiko informazioa.

Jatorria

Informazioa sortzen duen entitate batek beste entitate bati informazioa transmititzen diola esaten da, bigarrenak informazio hori aldez aurretik ez bazuen ezagutzen. Izan ere, aldez aurretik eta ziurtasun osoz ezagutuko balu, transmititutakoaren informazio kantitatea zero izango litzateke.

Etorkizuneko gertaera baten emaitza jakina bada aldez aurretik ziurtasun osoz, hau da 1eko probabilitatearekin, gertaera hori behatzeak ez du inolako informaziorik emango. Informazioa emango du hartzaileak ziurtasun osoz mezuaren edukia ez badu ezagutzen; ezaguna bada 1 baino txikiagoa den probabilitatez.

Gertaera bat behatzeak behatzaileari ematen dion informazioa, gertaera horren emaitzak duen probabilitatearen araberakoa da:

non emaitzak ematen duen informazio kantitatea den. funtzioa emaitzaren probabilitatearen funtzio bat da. Zera bete behar da:

denean ,

ezaguna den emaitza batek ez baitu informaziorik transmititzen. Zera ere bete behar da:

denean ,

ziurtasun osoz ezaguna ez den emaitza batek informazioa transmitituko duelako; handiagoa edo txikiagoa izango da, ziurgabetasun mailaren arabera.

Gainera, definizioz, informazio kantitatea batukorra da eta ez da negatiboa. gertakaria eta bi gertakari independenteren ebakidura bada, gertaerari buruzko mezuak ematen duen informazioa eta gertaerei buruzko mezuek batera ematen duten informazio bera da.

eta gertaerak independenteak direnez

Propietate hori kontutan izanik, funtzioari buruz beste zerbait jakin dezakegu

Beraz funtzioak honako propietatea du:

Propietate hori betetzen duten funtzioak logaritmikoak dira, edozein oinarritan. Oinarri ezberdinetako logaritmoen arteko desberdintasun bakarra faktore lineal bat da. Oinarri batetik bestera pasatzea erraza da, zera betetzen baita:

Oinarria finkatuz gero, adibidez, funtzioak honako itxura izango du:

Gertaeren probabilitateak 0 eta 1 balioen artean daudenez eta funtzioa negatiboa denez tarte horretan, izan beharko da tarte horretan positiboa izatea nahi baldin badugu.

-ren edozein balio negatibo zuzena izango litzateke informazio kantitatea definitzeko. -ren balio absolutuaren arabera funtzioak azkarrago edo geldoago dibergituko du argumentua (probabilitatea) 0ra hurbiltzen den ahala. -ren balioa aldatzea, mantentzea eta logaritmoaren oinarria aldatzearen baliokidea da. Ohikoena hartzea izaten da, hau da:

Interesgarria izan liteke adierazpen aljebraikoaren beste interpretazio hau aztertzea:

Gertakariaren probabilitatea logaritmoaren argumentuaren zatitzailean dagoenez, probabilitate altuagoek informazio kantitate txikiagoak eragingo dituzte eta alderantziz. Hori bat dator emandako definizioarekin.

ren balio ezberdinei dagokienez, finkatuz gero eta logaritmoaren oinarri moduan 2 aukeratuz (ohikoena), lortzen den informazio kantitatearen unitateari bit deritzo; oinarria denean (logaritmo nepertarra) nat da unitatea eta oinarria 10 denean informazio unitateari hartley deritzo.

Ikus, gainera

Informazio gehiagorako

- A Mathematical Theory of Communication. Claude Shannon.Bell Systems Technical Journal, Vol. 27, pp 379–423, (Part I), 1948.

Erreferentziak

- Jones, D.S., Elementary Information Theory, Vol., Clarendon Press, Oxford pp 11-15 1979