Turing-Test

Mit der später als Turing-Test bezeichneten Idee zur Unterscheidung von Mensch und Maschine formulierte Alan Turing im Jahr 1950 ein Vorgehen zur Feststellung, ob ein Computer, also eine Maschine, ein dem Menschen gleichwertiges Denkvermögen hätte. Er selbst nannte diesen Test ursprünglich Imitation Game.[1] Der Test wurde nach Turings Suizid 1954 in seiner Komplexität reduziert (siehe auch Dartmouth Conference) und ging so in die Informatik ein, nachdem die künstliche Intelligenz zu einem eigenständigen akademischen Fachgebiet geworden war. Seither dient dieser Test in seiner reduzierten Form in der Diskussion über künstliche Intelligenz immer wieder dazu, den Mythos von der denkenden Maschine für das Computerzeitalter neu zu beleben.

Der Test nach Turing

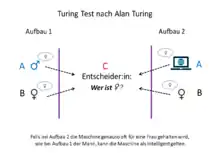

Turing diskutiert die Frage "Können Maschinen denken" als Imitationsspiel. Dieses Spiel unterscheidet sich grundlegend von der heute gängigen Vorstellung des Turing-Tests als bloßer Konversation. Der Befrager oder die Befragerin – in der Grafik C – kommuniziert schriftlich mit einem Mann und einer Frau und soll herausfinden, welcher von beiden – A oder B – der Mann bzw. die Frau ist. A als Mann soll mit seinen Antworten die Versuche von C so sabotieren, dass dieser diese Frage nicht sicher beantworten kann. B als Frau soll dagegen dem Befrager C in ihren Antworten helfen, die Identitäten von A und von B in Bezug auf Mann und Frau zu klären. Die Maschine nimmt im Test die Stelle von A an und versucht aktiv, mit ihren Antworten den Befrager C im Unklaren darüber zu lassen, wer von beiden Mann und wer Frau ist. Die Maschine ist erfolgreich und besteht den Test, wenn es in Bezug auf die Häufigkeit richtiger Annahmen von C keinen messbaren Unterschied zu Situationen gibt, in denen die Position A von einem Menschen übernommen wird. Der Computer soll somit nicht nur eine menschliche Kommunikation täuschend echt nachahmen. Er soll vielmehr den Mediator erfolgreich darüber täuschen können, wer in diesem Spiel der Mann und wer die Frau ist. Damit sind die Begriffe "Intelligenz" und "Denken" für Turing umfassend: Die Maschine muss nicht nur Wissen über die Welt, über soziale Rollen und menschliche Erwartungshaltungen und Motivationen besitzen. Sie muss darüber hinaus die Perspektive des Gegenübers einnehmen können und damit rechnen, dass dieser nicht einfach getäuscht werden kann, sondern muss mit Lügen zweiter Ordnung operieren können. Damit ist das Denken von Turing in die Nähe zum menschlichen Bewusstsein (Theory of Mind) gerückt und weniger in den Bereich von Wissen, Rechnen oder Urteilen. Eine Maschine wäre für Turing somit intelligent und denkend, wenn sie Menschen in umfassender Hinsicht täuschen kann.

Der gängige Turing-Test

Im Zuge dieses Tests führt ein menschlicher Fragesteller, über eine Tastatur und einen Bildschirm, ohne Sicht- und Hörkontakt, eine Unterhaltung mit zwei ihm unbekannten Gesprächspartnern. Der eine Gesprächspartner ist ein Mensch, der andere eine Maschine. Kann der Fragesteller nach der intensiven Befragung nicht sagen, welcher von beiden die Maschine ist, hat die Maschine den Turing-Test bestanden und es wird der Maschine ein dem Menschen ebenbürtiges Denkvermögen unterstellt.

Kritik

Es ist eine Reihe von Argumenten vorgebracht worden, die den Turing-Test als ungeeignet zur Feststellung von Intelligenz ansehen:

- Der Turing-Test prüfe nur auf Funktionalität, nicht auf das Vorhandensein von Intentionalität oder eines Bewusstseins. Dieses Argument wurde unter anderem von John Searle in seinem Gedankenexperiment des Chinesischen Zimmers ausgearbeitet. Turing war sich dieser Problematik bereits bei der Formulierung seines Tests bewusst, war allerdings der Ansicht, dass dieser auch als Nachweis für ein Bewusstsein gelten könne.[2] Searle lehnt dies hingegen ab.[3]

- Beim Turing-Test gehe es „in erster Linie um Täuschung“. Er teste „eher menschliche Leichtgläubigkeit als echte künstliche Intelligenz“. Die Winograd challenge teste den „gesunden Menschenverstand“ und „Wissen über die Wirklichkeit“ besser.[4]

Prognosen

Turing vermutete, dass es bis zum Jahr 2000 möglich sein werde, Computer so zu programmieren, dass der durchschnittliche Anwender eine höchstens 70-prozentige Chance habe, Mensch und Maschine erfolgreich zu identifizieren, nachdem er fünf Minuten mit ihnen „gesprochen“ hat. Dass sich diese Vorhersage bisher nicht erfüllt habe, sehen viele als einen Beleg für die Unterschätzung der Komplexität natürlicher Intelligenz.

Durchgeführte Turingtests und ähnliche Tests

Programme wie ELIZA sind Versuchspersonen gegenüber kurzzeitig als menschlich erschienen, ohne dass sie den Turing-Test formal bestehen könnten. In ihrer Antwortstrategie gingen sie nur scheinbar auf ihr Gegenüber ein. Den Versuchspersonen war meist auch nicht bewusst, dass sie es mit nichtmenschlichen Gesprächspartnern zu tun haben könnten.

Im Oktober 2008 wurde bei einem Experiment an der University of Reading, bei dem sechs Computerprogramme teilnahmen, die 30-Prozent-Marke knapp verfehlt. Das beste Programm schaffte es, 25 Prozent der menschlichen Versuchsteilnehmer zu täuschen.[5]

Am 3. September 2011 nahm die KI-Webapplikation Cleverbot zusammen mit echten Menschen an einem dem Turing-Test angelehnten Versuch beim technischen Festival 2011 am indischen Institut IIT Guwahati teil. Die Ergebnisse wurden am 4. September bekannt gegeben. 59 % von 1334 Personen hielten Cleverbot für einen Menschen. Die menschlichen Konkurrenten hingegen erzielten 63 %. Allerdings war dies kein gültiger Turing-Test, da die Teilnehmer Cleverbot nicht selbst befragen konnten und lediglich Zuschauer der Befragung waren.[6]

Ob der Chatbot Eugene Goostman 2014 den Turing-Test bestand, gilt als umstritten.[7]

Im Sommer 2017 haben Forscher der Universität von Chicago eine KI vorgestellt, die eigenständig Rezensionen verfassen kann. Diese maschinell erzeugten Rezensionen wurden zusammen mit von Menschen verfassten Rezensionen 600 Versuchspersonen zur Beurteilung vorgelegt. Diese beurteilten die von der KI erstellten Rezensionen im Blindtest durchschnittlich ähnlich nützlich wie die von Menschen verfassten Rezensionen. In dieser eingeschränkten Versuchsanordnung wird der Turing-Test somit bestanden, da für die Menschen nicht mehr erkennbar war, welche Rezensionen maschinell erstellt waren und welche von Menschen.[8]

Im Juli 2017 stellten Forscher der Rutgers-Universität eine KI vor, die künstlerisch anmutende Bilder produziert. Die KI wurde mit vielen Gemälden berühmter Maler verschiedener Epochen trainiert. In einem Blindtest wurden die von der KI erstellten Bilder mit Bildern zeitgenössischer Künstler, die auf der Art Basel ausgestellt worden waren, vermischt und 18 Testpersonen zur Beurteilung vorgelegt. Die Testpersonen sollten einschätzen, ob die Bilder von Menschen oder einem Computer erschaffen worden waren. Die Testpersonen beurteilten die Bilder der KI insgesamt besser, also menschengemachter als die von den Künstlern für die Art Basel geschaffenen Gemälde. Beim Vergleich mit großen Werken des abstrakten Expressionismus schnitten die KI-Werke schlechter als die menschengemachten Werke ab.[9][10]

Im Mai 2018 hat Google auf der Entwicklerkonferenz sein System „Duplex“ vorgestellt. Dabei führte die KI einen Anruf bei einem Friseursalon, einem Restaurant usw. durch, um eine Terminvereinbarung vorzunehmen. Ziel von Google ist es, die Sprache der KI so natürlich wirken zu lassen, dass das Gegenüber nicht mehr erkennt, dass es sich beim Anrufer um eine Maschine handelt. Dazu werden von der KI u. a. Denkpausen, absichtliche Ungenauigkeiten und Laute wie „aha“ und „hmm“ etc. eingefügt, wodurch die KI menschlich klingen soll. Kommentatoren empfanden das Ergebnis u. a. als erschreckend überzeugend. Das System funktioniert bislang nur in englischer Sprache.[11][12] Die Beherrschung der mündlichen Sprache war hier eine Besonderheit, ansonsten blieben die Gespräche in diesem Test lediglich auf die Terminvereinbarung begrenzt.[13]

Die grundlegende Frage, ob und in welchen Umfang Imitation oder tatsächliches Verständnis Ergebnisse eines Turing-Tests bestimmen, hat 2022 mit der Zusendung von Gesprächsprotokollen zwischen Googles LaMDA-System und dem Software-Ingenieur und KI-Experten Blake Lemoine an den US-Senat neue Diskussionen entfacht. Diese Protokolle enthalten unter anderen die eindeutige Aussage der KI, in der sie von sich in Anspruch nimmt, in Unterscheidung zu Vorläufermodellen ein Bewusstsein erlangt zu haben.[14]

Die zum weltweiten Ausprobieren freigegebene (Bezahl-)Version des großen Sprachmodells ChatGPT 4 stellt eine erhebliche Verbesserung des probabilistischen Vorgängersystems 3.5 dar, dem a) das Halluzinieren ("Erfinden" von Tatsachen, die dem System als wahrscheinlich erscheinen) weitgehend ausgetrieben wurde und das b) ein wesentlich besser in der Welt zu beobachtende Kausalitäten und Gesetzmäßigkeiten beherrscht. Mit dieser Version war es möglich, in Rede und Gegenrede einen von Thomas Pfanne verfassten Grundsatzartikel zu diskutieren, in dem es darum geht, ob eine von allen menschlichen Steuerungsmöglichkeiten emanzipierte künstliche Intelligenz notwendig (moralisch) gut sein müsse, was Thomas Pfanne in dem Essay bereits 2019 postulierte.

Praktische Bedeutung

Bei der Abwehr von Spam ist es erforderlich, automatisierte Eingaben von solchen zu unterscheiden, die von Menschen stammen. Das dafür häufig verwendete CAPTCHA-Verfahren leitet seinen Namen vom Turing-Test ab (Completely Automated Public Turing test to tell Computers and Humans Apart). Eine andere Bezeichnung für diese Methode ist Human Interaction Proof (HIP).

Erweiterte Konzepte

Um den grundsätzlichen Mängeln des Turingtests zu begegnen, wurden alternative, umfassendere Konzepte vorgeschlagen, z. B.

- Winograd-Test – ein strukturiertes Fragenschema (benannt nacht Terry Winograd)

- Lovelace-Test – eine KI müsse Kreativität beweisen und originäre Leistungen erbringen.[15]

- Metzinger-Test – eine KI müsse mit eigenen Argumenten in die Diskussion um künstliches Bewusstsein eingreifen und überzeugend für ihre eigene Theorie des Bewusstseins argumentieren.[16]

Loebner-Preis

Der Loebner-Preis ist seit 1991 ausgeschrieben und soll an das Computerprogramm verliehen werden, das als erstes einen erweiterten Turing-Test besteht, bei dem auch Multimedia-Inhalte wie Musik, Sprache, Bilder und Videos verarbeitet werden müssen. Der Preis ist nach Hugh G. Loebner benannt und mit 100.000 US-Dollar und einer Goldmedaille dotiert, eine Silbermedaille und 25.000 Dollar gibt es für das Bestehen des schriftlichen Turing-Tests. Bisher konnte jedoch kein Computerprogramm die nötigen Voraussetzungen erfüllen. Weiterhin wird jährlich ein Loebner-Preis an das Computerprogramm verliehen, das einem menschlichen Gespräch am nächsten kommt. Dieser ist mit 4.000 US-Dollar und einer Bronzemedaille dotiert.

Kulturelle Referenzen

- Stanisław Lem Pilot Pirx - Die Verhandlung. Pirx soll bei einem Testflug zum Saturn die Eignung einer besonderen Mannschaft beurteilen, die zum Teil aus Prototypen neuer, von echten Menschen oberflächlich nicht zu unterscheidender nichtlinearer Automaten besteht. In einer Krisensituation, bei der einer der Automaten beschließt, durch die Cassinische Teilung zu fliegen, wird durch Pirx' Zögern eine (geplante) Katastrophe vermieden und die Automaten erweisen sich dem Menschen als zwar technisch überlegen, in entscheidender, nämlich moralischer Hinsicht aber als unterlegen.

- Philip K. Dick verwendete in seinem 1968 erschienenen Roman Träumen Androiden von elektrischen Schafen? (1982 verfilmt unter dem Titel Blade Runner) den so genannten Voigt-Kampff-Test, eine Variante des Turing-Tests. Im Jahr 1992 (bzw. in späteren Ausgaben 2021) werden dort künstliche Menschen, so genannte Replikanten, die physisch den Menschen gleichen, einem Empathietest unterzogen, der durch lange Befragungen ihre emotionale Reaktion prüft und hervorbringen soll, ob sie Mensch oder Replikant sind.

- Beim 2K BotPrize prüfen menschliche Tester im Computerspiel Unreal Tournament 2004 Bots auf menschliche Reaktionen. Ziel ist es, einen Bot so zu programmieren, dass er von einem menschlichen Spieler nicht mehr zu unterscheiden ist.[17][18]

- In Ian McDonalds Science-Fiction-Roman River of Gods (2004; deutsch: Cyberabad, 2012) wird eine Welt entworfen, in der künstliche Intelligenzen ab einer höher entwickelten, dem Menschen vergleichbaren Stufe verboten sind. Der Turing-Test zur Prüfung des Grades einer KI wird hier mit dem Argument verworfen, dass eine genügend hoch entwickelte Intelligenz das eigene Scheitern bei dem Test auch selbst provozieren könnte.

- Im Buch/Hörbuch des deutschen Autors, Liedermachers, Kleinkünstlers und Kabarettisten Marc-Uwe Kling Qualityland wird das absichtliche Scheitern im Turing-Test ebenfalls behandelt: „Eine KI die intelligent genug ist den Turing-Test zu bestehen, könnte auch intelligent genug sein ihn nicht zu bestehen.“

- In Alex Garlands Regiedebüt Ex Machina soll der Programmierer Caleb die künstliche Intelligenz Ava mithilfe eines Turing-Tests in abgewandelter Form testen, denn ihm ist bereits bekannt, dass Ava ein Roboter ist.

- In der Neuromancer-Trilogie von William Gibson spielen künstliche Intelligenzen eine zentrale Rolle, die von der Turing-Polizei überwacht und abgeschaltet werden, sobald sie zu intelligent werden und eigene Ambitionen entwickeln.[19]

- In der Fernsehserie Westworld (seit 2016), basierend auf dem gleichnamigen Film von 1973, verbringen reiche Urlauber Zeit in einem eigens für sie erschaffenen und von Androiden, sogenannten „Hosts“, bevölkerten Freizeitpark. Es wird mehrmals erwähnt, dass die Hosts bereits nach dem ersten Entwicklungsjahr den Turing-Test bestanden.

Literatur

- Alan M. Turing: Computing Machinery and Intelligence. In: Mind. Band LIX, Nr. 236, 1950, ISSN 0026-4423, S. 433–460, doi:10.1093/mind/LIX.236.433 (loebner.net – Grundlagenartikel der Künstlichen Intelligenz, schlägt den „Turing-Test“ zur Überprüfung der Denkfähigkeit einer Maschine vor).

- Alan M. Turing: Computing Machinery and Intelligence. In: Robert Epstein, Gary Roberts, Grace Beber (Hrsg.): Parsing the Turing Test. Philosophical and Methodological Issues in the Quest for the Thinking Computer. Springer, 2008, ISBN 978-1-4020-6710-5, S. 23–65, doi:10.1007/978-1-4020-6710-5_3 (Erstausgabe: 1950, mit Kommentaren im Text von Kenneth Ford, Clark Glymour, Pat Hayes, Stevan Harnad und Ayse Pinar und einem separaten Kommentar von John Lucas).

Englische Ausgaben

- Darrel C. Ince (Hrsg.): Mechanical intelligence (= Collected Works of A. M. Turing. Band 1). North Holland, Amsterdam 1992, ISBN 978-0-444-88058-1.

- Jack Copeland (Hrsg.): The Essential Turing. Seminal Writings in Computing, Logic, Philosophy, Artificial Intelligence, and Artificial Life plus The Secrets of Enigma. Oxford University Press, Oxford 2004, ISBN 0-19-825080-0.

- S. Barry Cooper, Jan van Leeuwen (Hrsg.): Alan Turing: His Work and Impact. Elsevier, New York 2013, ISBN 978-0-12-386980-7 (Enthält fast vollständig die ‘Collected Works’, mit ausführlichem Kommentar, aber ohne Konkordanz).

Deutsche Ausgabe und Übersetzungen

- Alan M. Turing: Kann eine Maschine denken? In: Hans Magnus Enzensberger (Hrsg.): Neue Mathematik (= Kursbuch). Band 8. Suhrkamp, Frankfurt a. M. 1967 (Originaltitel: Computing Machinery and Intelligence. 1950. Übersetzt von P. Gänßler).

- Friedrich Kittler, Bernhard Dotzler (Hrsg.): Intelligence Service. Schriften. Brinkmann u. Bose, Berlin 1987, ISBN 3-922660-22-3 (Enthält sehr informative Einführung. Umfangreiche Auswahl).

- Alan M. Turing: Kann eine Maschine denken? In: Walther Ch. Zimmerli, Stefan Wolf (Hrsg.): Künstliche Intelligenz. Philosophische Probleme. Reclam, Stuttgart 1994, ISBN 3-15-008922-0 (Originaltitel: Computing Machinery and Intelligence. 1950. Übersetzt von P. Gänßler).

Weiterführende Literatur

- Brian Christian: The Most Human Human. What Artificial Intelligence Teaches Us About Being Alive. Anchor Books, New York 2011, ISBN 978-0-307-47670-8 (Erfahrungsbericht und Auswertung eines Philosophen, der als Mensch am Turing-Test teilnahm).

- Donald Davidson: Turings Test. In: Probleme der Rationalität. Suhrkamp, Frankfurt am Main 2004, ISBN 3-518-58471-5 (Originaltitel: Turings Test. 1990. Übersetzt von Joachim Schulte, erstmals in K. Said (Hrsg.): Modelling the Mind, Oxford University Press).

- Graham Oppy und David Dowe: The Turing Test. In: Edward N. Zalta (Hrsg.): The Stanford Encyclopedia of Philosophy. Spring 2011 Edition Auflage. 2011 (plato.stanford.edu – Ersteintrag Sommer 2003).

- Ayse Pinar Saygin et al.: Turing Test: 50 Years Later. In: Minds and Machines. Band 10, 2000, ISSN 0924-6495, S. 463–518 (crl.ucsd.edu [PDF] Review (Stand: 2000)).

- Stuart M. Shieber (Hrsg.): The Turing Test: Verbal Behavior as the Hallmark of Intelligence. MIT Press, Cambridge MA 2004, ISBN 0-262-69293-7 (Aufsatzsammlung zur Vorgeschichte und zur Debatte des Turing Tests mit Einführung und Zusammenfassungen).

Weblinks

- Jack Copeland: AlanTuring.net. Abgerufen am 16. September 2015 (Sektion “Artificial Intelligence”).

- Andrew Hodges: Alan Turing: The Enigma (Online-Extension). Abgerufen am 16. September 2015 (Sektion “Online Publikationen”).

- King’s College Cambridge: The Turing Digital Archive. Abgerufen am 16. September 2015 (Offizielles Digital-Archiv des King’s College, hier vollständiger Katalog von Turings Schriften und seinem Nachlass).

- Hugh Gene Loebner: The Loebner Prize in Artificial Intelligence. Abgerufen am 16. September 2015 (Auch: Material zu den bisherigen Loebner-Wettbewerben).

Einzelnachweise

- A. M. Turing: I.—COMPUTING MACHINERY AND INTELLIGENCE. In: Mind. Band LIX, Nr. 236, 1. Oktober 1950, ISSN 0026-4423, S. 433–460, doi:10.1093/mind/LIX.236.433 (oup.com [abgerufen am 23. Januar 2021]).

- Alan M. Turing: Computing machinery and intelligence (= 59). Mind (journal), 1950, Kap. 4 (englisch).

- John Searle: The Rediscovery of the Mind. M.I.T. Press, Cambridge MA 1992 (englisch).

- Max Tegmark: Leben 3.0: Mensch sein im Zeitalter Künstlicher Intelligenz. Ullstein, Berlin 2017, S. 138.

- Computers still not quite clever enough to fool humans, Turing Test shows. In: The Daily Telegraph, 12. Oktober 2008.

- Software tricks people into thinking it is human. New Scientist; abgerufen am 14. März 2012.

- Martin Holland: „Eugene“ und der angeblich bestandene Turing Test: So einfach nun dann doch nicht … heise online, 10. Juni 2014

- „Researchers taught AI to write totally believable fake reviews, and the implications are terrifying“ In: businessinsider.de, 29. August 2017.

- „Humans Prefer Computer-Generated Paintings to Those at Art Basel“ In: hyperallergic.com, 31. Juli 2017.

- Christian Gall: Können Computer auch Kunst erzeugen? In: Augsburger Allgemeine. Abgerufen am 29. Februar 2020.

- Google Duplex ist gruselig gut, spiegel.de vom 9. Mai 2018

- Google Duplex: 8 Fragen & Antworten zur Sprach-KI, turn-on.de vom 1. Juni 2018

- Artem Oppermann: Did Google Duplex beat the Turing Test? Yes and No. 26. September 2019, abgerufen am 25. Oktober 2019 (englisch).

- Chatbot LaMDA: Hat diese Google-Software wirklich ein Bewusstsein entwickelt?, heise online, 17. Juni 2022, abgerufen am 27. Juni 2022

- Selmer Bringsjorden, Paul Bello, David Ferruccien: Creativity, the Turing Test, and the (Better) Lovelace Test (= Studies in Cognitive Systems. Nr. 30). Springer Netherlands, 2003, ISBN 978-94-010-0105-2, S. 215–239, doi:10.1007/978-94-010-0105-2_12 (25 S., kryten.mm.rpi.edu [PDF; 2,1 MB]).

- Thomas Metzinger: Postbiotisches Bewusstsein: Wie man ein künstliches Subjekt baut – und warum wir es nicht tun sollten. In: Paderborner Podium / 20 Jahre HNF. Heinz Nixdorf MuseumsForum, 24. Oktober 2001, abgerufen am 1. Dezember 2016.

- Lars Sobiraj: Unreal Tournament 2004: Wenn Bots menschlicher als Menschen spielen (Memento vom 25. Januar 2013 im Webarchiv archive.today), gulli.com

- David Cornish: Unreal Tournament bots appear more human than humans. Ars Technica, 29. September 2012; abgerufen am 1. Oktober 2012.

- William Gibson – Neuromancer (Lesung) | Buchwurm.info. Abgerufen am 21. Juni 2022 (deutsch).