Computational Neuroscience

Computational Neuroscience (von engl. computation: Berechnung, Informationsverarbeitung, und Neuroscience: Neurowissenschaften, Hirnforschung; meist synonym zu Theoretische Neurowissenschaft) ist eine interdisziplinäre Wissenschaftsrichtung, die sich mit den informationsverarbeitenden Eigenschaften des Nervensystems beschäftigt.[1] Der Begriff der Informationsverarbeitung umfasst verschiedene Stufen der Wahrnehmung, kognitiven Funktionen wie Lernen, Gedächtnis, Entscheidungsfindung, als auch die Steuerung des motorischen Systems zur Ausführung von Handlungen.

Methodik

Das wichtigste methodische Werkzeug der Computational Neuroscience ist die mathematische Modellierung von Bestandteilen des Nervensystems wie Nervenzellen, Synapsen und neuronalen Netzwerken mit den Methoden und Erkenntnissen der Biophysik und der Theorie der dynamischen und komplexen Systeme. Diese Modelle werden aufgrund ihrer Komplexität oft im Computer simuliert. Außerdem stellt die Computational Neuroscience auch Analysemethoden experimenteller neuronaler Daten zur Verfügung. Bei all diesen Ansätzen ist eine enge Zusammenarbeit von experimentell arbeitenden Wissenschaftlern aus den Disziplinen Biologie, Medizin, Psychologie und Physik sowie Theoretikern aus der Mathematik, Physik und Informatik erforderlich. Die experimentellen Daten bieten sowohl die Grundlage für die Modelle (z. B. elektrophysiologische Eigenschaften von Nervenzellen und Synapsen, Netzwerkstrukturen in realen Nervennetzen) als auch die Möglichkeit zum Testen ihrer Vorhersagen, etwa über bestimmte dynamische oder informationsverarbeitende Eigenschaften. Die Modelle wiederum bieten die Möglichkeit, die oftmals vielfältigen und z. B. widersprüchlich erscheinenden Ergebnisse der Experimente systematisch zu ordnen und durch mathematische Analyse und Simulation komplexe Zusammenhänge zu erkennen, die ohne diese Methode nur schwer oder gar nicht zu erfassen sind.

Gegenstand der Modellierung sind Strukturen auf allen Größen- und Komplexitätsskalen, angefangen von biophysikalischen Simulationen der molekularen Dynamik bestimmter Ionenkanäle und Neurotransmitter, über Modelle einzelner Nervenzellen, bis hin zu komplexen Netzwerkmodellen, die Interaktionen zwischen Hirnregionen nachbilden. Abhängig von der Fragestellung können diese Modelle sehr unterschiedliche Abstraktionsgrade aufweisen, d. h., entweder eng an experimentelle Daten angelegt werden oder eher die generellen Prinzipien und Strukturen abbilden und formalisieren, die aus den Experimenten gewonnen wurden.

Verwandte Disziplinen

Computational Neuroscience kann bis zu einem gewissen Grad gegenüber konnektionistischen Theorien der Psychologie, reinen Lerntheorien wie Maschinellem Lernen und künstlichen neuronalen Netzwerken sowie dem Gebiet der Neuroinformatik abgegrenzt werden, obgleich diese Gebiete zum Teil parallele Entwicklungsgeschichten haben und teilweise auch ähnliche Ziele verfolgen. Modellierungsansätze der Computational Neuroscience haben den Anspruch, bestimmte Aspekte der neuronalen Strukturen biologisch realistisch abzubilden und direkte Vorhersagen über entsprechende Experimente zu machen. Konnektionistische Modelle verfolgen ein ähnliches Vorhersageziel auf der Ebene psychophysikalischer Experimente, haben aber nur einen eingeschränkten Anspruch auf biologischen Realismus, der sich auf die Struktur der Verknüpfungen und die Fähigkeit zum Lernen beschränkt. Ähnliches gilt für die Lerntheorien, die aber oft zusätzlich auch für rein technische Zwecke verwendet werden, etwa für die Vorhersage einer komplexen Zeitreihe oder zur Mustererkennung in Bildern. In diesen anwendungsorientierten Bereichen spielt die Analogie zum Gehirn nur eine untergeordnete Rolle, ein Verständnis menschlicher Informationsverarbeitung wird nicht angestrebt. Die Neuroinformatik schließlich nimmt, ihrem Namen folgend, eine informationstheoretische Sichtweise auf die Neurowissenschaften ein. Das beinhaltet unter anderem die Entwicklung von Datenbanken, Datenstrukturen und Standards zur effizienten Speicherung, Archivierung und zum Austausch experimenteller Daten sowie die Entwicklung von Software sowohl zur Modellierung neuronaler Systeme (z. B. Neuron, Genesis, NEST) und zur Erfassung und Analyse experimenteller Daten.[2] Abstraktere Ansätze wie künstliche neuronale Netzwerke und maschinelles Lernen werden bisweilen ebenfalls der Neuroinformatik zugerechnet.[2]

Forschungsthemen

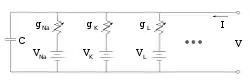

Ein frühes Neuronenmodell (1952), das, teilweise modifiziert, oft die Grundlage heutiger Software ist, ist das Hodgkin-Huxley-Modell. Ausgehend von einer Beschreibung der durch Ionenkanäle entscheidend beeinflussten elektrischen Eigenschaften der Zellmembran von Neuronen in Form eines Ersatzschaltbildes modelliert es die Entstehung von Aktionspotentialen. Die in den vielfältigen Modellen eingesetzten mathematischen Methoden stammen überwiegend aus der Theorie dynamischer Systeme. Dem teilweise sprunghaften Verhalten von Neuronen (z. B. im Bereich des Schwellenpotentials) wird durch Bifurkationen Rechnung getragen.[3]

Beispiele für die Anwendung solcher Modelle sind die Beschreibung von Zellen in den Basalganglien, mit dem Ziel, neue Therapieansätze für die Parkinson-Krankheit zu entwickeln,[4] bei denen auch die Modellierung einzelner Zellen (wie z. B. mit der Software Neuron möglich) wichtig ist, und Versuche, komplexe kognitive Prozesse wie im Stroop-Test mit dem Programm Emergent zu beschreiben, wobei zusätzliche Effekte wie die Hebbsche Lernregel eine Rolle spielen, aber einzelne Zellen aufgrund der berücksichtigten Anzahl deutlich stärker vereinfacht werden.[5]

Geschichte

Der Begriff „Computational Neuroscience“ wurde 1985 von Eric L. Schwartz eingeführt. Schwartz hatte in diesem Jahr auf Anfrage der Systems Development Foundation eine Konferenz in Carmel, Kalifornien organisiert. Diese hatte zum Ziel, einen Überblick über eine Wissenschaftsrichtung zu geben, die bis dahin mit einer Reihe verschiedener Begriffen wie „neuronale Modellierung“, „Gehirntheorie“ oder „neuronale Netzwerke“ assoziiert war. Die Beiträge zu dieser Konferenz wurden 1990 in einem Buch mit dem Namen „Computational Neuroscience“ veröffentlicht.

Die frühe Geschichte dieses Gebiets ist eng verknüpft mit den Namen von Wissenschaftlern wie Louis Lapicque (1866–1952), Alan Lloyd Hodgkin und Andrew Fielding Huxley, Wilfrid Rall, David H. Hubel und Torsten N. Wiesel, und David Marr.

Lapicque führte 1907 das Integrate-and-Fire-Neuronenmodell ein, das wegen seiner Einfachheit bis heute eines der beliebtesten Modelle der Computational Neuroscience darstellt. Knapp 50 Jahre später studierten Hodgkin und Huxley das experimentell besonders gut zugängliche Riesenaxon des Tintenfischs und leiteten aus ihren Untersuchungen das erste biophysikalische Modell des Aktionspotentials ab (Hodgkin-Huxley-Modell), das sie 1952 veröffentlichten. Rall erweiterte dieses Modell um die Kabeltheorie, die die Grundlage für Neuronenmodelle legte, die aus räumlich ausgedehnten Teilen der Zelle (Soma, Axon, Dentriten) zusammengesetzt sind. Heute werden solche Modelle zur morphologisch exakten Simulation z. B. mithilfe von Neuron benutzt.

Hubel und Wiesel forschten an den Zellen des primären visuellen Cortex, dem ersten Areal der Großhirnrinde, die visuelle Informationen aus der Netzhaut aufnimmt. Sie entdeckten unter anderem, dass die Zellen des primären visuellen Cortex nicht nur die räumliche Struktur des Bildes auf der Netzhaut widerspiegeln, sondern auch die räumliche Orientierung der wahrgenommenen Objekte auslesen können. Sowohl Hodgkin und Huxley als auch Hubel und Wiesel erhielten für ihre Arbeiten den Nobelpreis für Physiologie oder Medizin (1963 und 1981).

Marrs Arbeiten konzentrierten sich auf die Interaktionen zwischen Neuronen verschiedener Areale wie z. B. dem Hippocampus und der Großhirnrinde. Er legte eine Theorie des Sehens vor, die sich an den Prinzipien der elektronischen Datenverarbeitung im Computer orientiert. Er gilt als einer der Begründer der Neuroinformatik.

Literatur

- Larry F. Abbott, Peter Dayan: Theoretical neuroscience: computational and mathematical modeling of neural systems. MIT Press, Cambridge, Mass 2001, ISBN 0-262-04199-5.

- William Bialek, Fred Rieke, David Warland, Rob de Ruyter van Steveninck: Spikes: exploring the neural code. MIT Press, Cambridge, Mass 1999, ISBN 0-262-68108-0.

- Alla Borisyuk, G. Bard Ermentrout, Avner Friedman, David Terman: Tutorials in Mathematical Biosciences 1: Mathematical Neuroscience: v. 1. Springer, Berlin 2005, ISBN 3-540-23858-1.

Weblinks

- Encyclopedia of Computational Neuroscience (Scholarpedia, engl.)

- Forschungsverbund Bernstein Netzwerk zu Computational Neuroscience

- Review (PDF; 944 kB)– Sejnowski TJ, Koch C, Churchland PS: Computational neuroscience. In: Science. 241. Jahrgang, Nr. 4871, September 1988, S. 1299–306, doi:10.1126/science.3045969, PMID 3045969.

Einzelnachweise

- Terrence J. Sejnowski, Christof Koch, Patricia S. Churchland: Computational Neuroscience. In: Science. Band 241, Nr. 4871, 9. September 1988, ISSN 0036-8075, S. 1299–1306, doi:10.1126/science.3045969.

- Losiana Nayak, Abhijit Dasgupta, Ritankar Das, Kuntal Ghosh, Rajat K. De: Computational neuroscience and neuroinformatics: Recent progress and resources. In: Journal of Biosciences. Band 43, Nr. 5, Dezember 2018, ISSN 0973-7138, S. 1037–1054, PMID 30541962.

- Alla Borisyuk, G. Bard Ermentrout, Avner Friedman, David Terman: Tutorials in Mathematical Biosciences 1: Mathematical Neuroscience: v. 1 (Lecture Notes in Mathematics). Springer, Berlin 2005, ISBN 3-540-23858-1.

- J.E. Rubin, D. Terman, High Frequency Stimulation of the Subthalamic Nucleus Eliminates Pathological Thalamic Rhythmicity in a Computational Model. In: Journal of Computational Neuroscience 16, 2004, 211–235

- Herd, S.A., Banich, M.T. & O’Reilly, R.C. (2006). Neural Mechanisms of Cognitive Control: An integrative Model of Stroop Task Performance and fMRI data. Journal of Cognitive Neuroscience, 18, 22–32.