Technologische Singularität

Unter dem Begriff technologische Singularität werden verschiedene Theorien in der Zukunftsforschung zusammengefasst. Überwiegend wird darunter ein hypothetischer zukünftiger Zeitpunkt verstanden, an dem künstliche Intelligenz (KI) die menschliche Intelligenz übertrifft und sich dadurch rasant selbst verbessern und neue Erfindungen machen würde, wodurch der technische Fortschritt irreversibel und derart beschleunigt würde, dass die Zukunft der Menschheit nach diesem Ereignis nicht mehr vorhersehbar wäre. Die erste Superintelligenz wäre damit die letzte Erfindung der Menschheit, da spätere Innovationen weitestgehend unabhängig von menschlichen Akteuren durch Maschinen entwickelt würden.[1]

Populär wurde der Begriff durch das 2005 erschienene Buch The Singularity Is Near: When Humans Transcend Biology (deutscher Titel: „Menschheit 2.0: Die Singularität naht“) des US-amerikanischen Computerpioniers und Autors Raymond Kurzweil,[1][2] der das Datum der Singularität auf das Jahr 2045 schätzt.[1]

Der prognostizierte Zeitpunkt der Singularität wurde von Zukunftsforschern mehrfach um Jahrzehnte in die Zukunft verschoben. Allerdings sei wahrscheinlich, dass sie überraschend eintritt, womöglich selbst für die an der Entwicklung Beteiligten.[3] Die Entwicklung einer Seed AI beschreibt eines dieser Szenarien.

Der Begriff ist eng verbunden mit den Theorien und Ideen des Transhumanismus. Einige ihrer Vertreter gehen davon aus, dass sich durch den damit verbundenen technologischen Fortschritt die Dauer der menschlichen Lebenserwartung maßgeblich steigern bzw. sogar biologische Unsterblichkeit erreichen lasse.[4][5]

Inhalt der Theorie

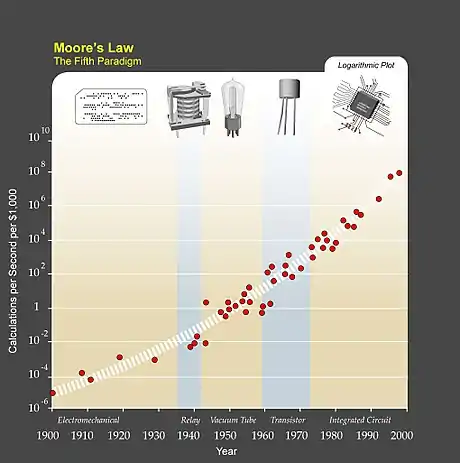

Der Erwartung einer technologischen Singularität liegt die Beobachtung zugrunde, dass sich Technik und Wissenschaft seit Anbeginn der Menschheit immer rascher weiterentwickeln und viele zahlenmäßig beschreibbare Phänomene wie Wissens- und Wirtschaftsentwicklung einem mindestens exponentiellen Wachstum folgen. Dazu zählt insbesondere die Rechenleistung von Computern, worauf Gordon Moore 1965 hinwies (Mooresches Gesetz). Seit etwa 1940 verdoppelt sich die für 1.000 US-Dollar erhältliche Rechenleistung in kürzer werdenden Zeitintervallen, zuletzt (Stand 2009 oder früher) alle 18 Monate, bisher insgesamt um zwölf dezimale Größenordnungen. Diesem rasanten technischen Fortschritt stehe die konstante Leistungsfähigkeit des menschlichen Gehirns bezüglich bestimmter Fähigkeiten gegenüber. Hans Moravec bezifferte die Rechenleistung des Gehirns zunächst auf 100 Teraflops, Raymond Kurzweil auf 10.000 Teraflops. Diese Rechenleistung haben Supercomputer bereits deutlich überschritten. Zum Vergleich lag eine Grafikkarte für 800 Euro im Juli 2019 bei einer Leistung von 11 Teraflops.[6] Auch wenn man der menschlichen Denkfähigkeit eine höhere Rechenleistung zuordne, sei demnach die technologische Singularität nur eine Frage der Zeit.

Anthony Berglas wagt am Beispiel der Spracherkennung einen groben Vergleich der Rechenleistung von Mensch und Computer. Mit Stand von 2012 würden Desktopcomputer für eine Spracherkennung auf menschlichem Niveau ausreichen. Im menschlichen Gehirn machen bekannte Regionen, die zur Spracherkennung verwendet werden, vermutlich jedoch nur 0,01 % des Gesamtgehirns aus. Ließe sich die restliche menschliche Intelligenz ebenso gut in Algorithmen umsetzen, fehlten nur wenige Größenordnungen, bis Computer die Denkfähigkeit von Menschen erreichen.[7] An der Stelle geht Berglas nicht darauf ein, welche über das bloße Identifizieren der gesprochenen Wörter hinausgehende Funktionalität die in diesem Vergleich genannten Hirnregionen bieten.

Als weitere Grundbedingung für eine Singularität kommt neben der reinen Rechenleistung die starke künstliche Intelligenz hinzu, die nicht speziell für eine Aufgabe programmiert werden muss. Eine starke künstliche Intelligenz mit mehr Rechenleistung als das menschliche Gehirn wäre eine sogenannte Superintelligenz. Würde sie sich selbst verbessern, käme es zu einem rasanten technischen Fortschritt, dem die Menschen verstandesmäßig nicht mehr folgen könnten. Ein starkes KI-System muss nicht viele Gemeinsamkeiten mit dem Menschen haben. Es wird wahrscheinlich eine andersartige kognitive Architektur aufweisen und in seinen Entwicklungsstadien ebenfalls nicht mit den evolutionären kognitiven Stadien des menschlichen Denkens vergleichbar sein (Evolution des Denkens). Vor allem ist nicht anzunehmen, dass eine künstliche Intelligenz Gefühle wie Liebe, Hass, Angst oder Freude besitzt.[8]

Entwicklung der Theorien

Erste Erwähnungen (1958–1970)

Die erste bekannte Erwähnung des Konzepts einer technologischen Singularität geht auf Stanisław Ulam zurück, der sich im Mai 1958 folgendermaßen zu einer Unterhaltung mit John von Neumann äußerte:

„Ein Gespräch drehte sich um die stete Beschleunigung des technischen Fortschritts und der Veränderungen im Lebenswandel, die den Anschein macht, auf eine entscheidende Singularität in der Geschichte der Menschheit hinauszulaufen, nach der die Lebensverhältnisse, so wie wir sie kennen, sich nicht fortsetzen könnten.“[9]

1965 beschrieb der Statistiker I. J. Good ein Konzept, das der heute vorherrschenden Bedeutung von Singularität insofern noch näher kam, als es die Rolle künstlicher Intelligenz mit einbezog:

„Eine ultraintelligente Maschine sei definiert als eine Maschine, die die intellektuellen Fähigkeiten jedes Menschen, und sei er noch so intelligent, bei weitem übertreffen kann. Da der Bau eben solcher Maschinen eine dieser intellektuellen Fähigkeiten ist, kann eine ultraintelligente Maschine noch bessere Maschinen bauen; zweifellos würde es dann zu einer explosionsartigen Entwicklung der Intelligenz kommen, und die menschliche Intelligenz würde weit dahinter zurückbleiben. Die erste ultraintelligente Maschine ist also die letzte Erfindung, die der Mensch zu machen hat.“

Auch die 1970 erschienene wirtschaftliche Trendanalyse Future Shock von Alvin Toffler bezog sich auf die Singularität.

Vernor Vinge und Ray Kurzweil

In den 80er Jahren begann der Mathematiker und Autor Vernor Vinge von einer Singularität zu sprechen, 1993 veröffentlichte er seine Ideen in dem Artikel Technological Singularity.[10] Daraus stammt auch die häufig zitierte Prognose, dass wir „innerhalb von 30 Jahren über die technologischen Mittel verfügen werden, um übermenschliche Intelligenz zu schaffen. Wenig später ist die Ära der Menschen beendet.“

Vinge postuliert, dass übermenschliche Intelligenz, unabhängig davon, ob durch kybernetisch erweiterte menschliche Intelligenz oder durch künstliche Intelligenz erreicht, wiederum noch besser dazu in der Lage sein werde, ihre Intelligenz zu steigern. „Wenn Fortschritt von übermenschlicher Intelligenz vorangetrieben wird“, so Vinge, „wird dieser Fortschritt deutlich schneller ablaufen.“ Diese Art von Rückkopplung soll zu enormem Fortschritt in sehr kurzer Zeit führen (Intelligenzexplosion).

In dem 2001 veröffentlichten Artikel The Law of Accelerating Returns stellt Ray Kurzweil die These auf, dass das Mooresche Gesetz nur ein Spezialfall eines allgemeineren Gesetzes sei, nach dem die gesamte technologische Evolution verlaufe.[11] Er glaubt, dass das durch das Mooresche Gesetz beschriebene exponentielle Wachstum sich auch in den Technologien fortsetzen werde, die die heutigen Mikroprozessoren ablösen werden, und letztendlich zur Singularität führen werde, die er als „technischen Wandel“ definiert, der „so schnell und allumfassend ist, dass er einen Bruch in der Struktur der Geschichte der Menschheit darstellt.“

Technologien

Zukunftsforscher spekulieren über verschiedene Technologien, die zum Eintreten einer Singularität beitragen könnten. Allerdings herrscht keine Einigkeit darüber, wann und ob diese Technologien überhaupt verwirklicht werden können.

Eine künstliche Intelligenz mit der Fähigkeit, sich selbst zu verbessern, wird als „Seed AI“ bezeichnet. Viele Anhänger der Singularität meinen, eine Seed AI sei die wahrscheinlichste Ursache einer Singularität.

Viele Anhänger der Singularität halten die Nanotechnologie für eine der größten Bedrohungen der Zukunft der Menschheit (Grey Goo). Aus diesem Grund fordern einige, dass molekulare Nanotechnologie nicht vor Auftreten einer Seed AI praktiziert wird. Das Foresight Institute vertritt dagegen die Meinung, dass ein verantwortungsvoller Umgang mit dieser Technologie auch in Präsingularitätszeiten möglich sei und die Realisierung einer für die Menschheit positiven Singularität dadurch beschleunigt werden könne.

Neben künstlicher Intelligenz und Nanotechnologie wurden auch andere Technologien mit der Singularität in Zusammenhang gebracht: Direkte Gehirn-Computer-Schnittstellen, die zu dem Bereich Augmented Intelligence gezählt werden, könnten zu verbessertem Gedächtnis, umfangreicherem Wissen oder größerer Rechenkapazität unseres Gehirns führen. Auch Sprach- und Handschrifterkennung, leistungssteigernde Medikamente und gentechnische Methoden fallen in diesen Bereich.

Als alternative Methode zur Schaffung künstlicher Intelligenz wurde, in erster Linie von Science-Fiction-Autoren wie Roger Zelazny, die Methode des Mind Uploading vorgeschlagen. Anstatt Intelligenz direkt zu programmieren, wird hier der Aufbau eines menschlichen Gehirns per Scan in den Computer übertragen. Die dazu nötige Auflösung des Scanners, die benötigte Rechenkraft und das erforderliche Wissen über das Gehirn machen das in der Präsingularitätszeit jedoch eher unwahrscheinlich.

Daneben wurde noch die Emergenz intelligenten Verhaltens aus einem hinreichend komplexen Computernetzwerk, sogenannte Schwarmintelligenz, in Betracht gezogen, beispielsweise von George Dyson in dem Buch Darwin Among the Machines.

Die potenzielle Leistungsfähigkeit von Quantencomputern – sollten sie je auf viele Qbits skalierbar sein – ist immens. Gleichzeitig sind Quantencomputer schwer zu programmieren, weil erstens jede Operation alle 2n überlagerten Zustände tangiert und zweitens die Rechnung nicht verfolgt werden kann: Nur am Ende der Rechnung, nach dem Kollaps der Wellenfunktion, ergeben sich n Bits als Ergebnis. Dieses Paradoxon ließ Michael Nielsen auf dem Singularity Summit spekulieren, dass erst die künstlichen Intelligenzen jenseits der Singularität in der Lage sein könnten, Quantencomputer sinnvoll zu benutzen, dass dann aber eine zweite Singularität eintreten könnte, nach der auf Quantencomputern ausgeführte Intelligenzen für ihre Programmierer ebenso unfassbar agierten, wie die klassischen KIs für uns Menschen.[12]

Auswirkungen

Die technologische Singularität begrenze den menschlichen Erfahrungshorizont, so die Vertreter der Hypothese. Die entstandene Superintelligenz könnte ein Verständnis der Wirklichkeit erwerben, das jegliche Vorstellungskraft sprengt; die Auswirkungen könnten damit vom menschlichen Bewusstsein zu keinem gegenwärtigen Zeitpunkt erfasst werden, da sie von einer Intelligenz bestimmt würden, die der menschlichen fortwährend überlegen wäre. Die Evolution könnte aus dem Bereich der Biologie in den der Technik wechseln.

Etliche Befürworter aus den Reihen des Transhumanismus sehnen die technologische Singularität herbei. Sie vertreten die Ansicht, sie sei der Endpunkt, auf den die Evolution zwangsläufig hinauslaufen werde. Letztlich erhoffen sie die Erschaffung übermenschlicher Wesen, die eine Antwort auf den Sinn des Lebens liefern oder das Universum einfach nur in einen lebenswerteren Ort verwandeln. Eine Gefahr sehen sie in dieser höheren Intelligenz nicht, denn gerade weil sie höher entwickelt sei, verfüge sie über ein dem Menschen überlegenes, friedfertiges ethisches Bewusstsein.

Laut Ray Kurzweil wird die Geschwindigkeit der durch technischen Fortschritt verursachten Veränderung in verschiedenen Lebensbereichen in den 2040er Jahren so schnell sein, dass es ohne die Erhöhung der eigenen Intelligenz durch intelligente Technologien nicht mehr möglich sei, ihr zu folgen.[13] Schlussendlich werde die technologische Singularität eine Auswirkung auf alle Lebensbereiche haben und die Menschheit in die Lage versetzen, all ihre physischen Bedürfnisse zu befriedigen.[14]

Kritiker betonen indes, dass das Eintreten einer technologischen Singularität verhindert werden müsse. Eine überlegene Intelligenz gehe nicht zwangsläufig mit einer friedfertigen Gesinnung einher und die entstehende Superintelligenz könne die Menschheit mühelos ausrotten. Sie sehen bereits im Streben nach einer technologischen Singularität einen Fehler, denn Sinn und Zweck von Technologie sei es gerade, den Menschen das Leben zu erleichtern; für sich selbst denkende Technologie verstoße gegen diesen Zweck und sei daher nicht erstrebenswert.

Das Thema maschinell eigenständiger, ethischer Ziel- und Wertefindung im Rahmen von Superintelligenz und technologischer Singularität wird als Wertgebungsproblem diskutiert.

Wirtschaft

In den aktuellen Jahren, die der technologischen Singularität vorausgehen, sieht der US-Autor Kartik Gada bereits deflationäre Auswirkungen aufgrund exponentieller technologischer Fortschritte. Angesichts dieser Entwicklungen sollten Zentralbanken laut Gada in Erwägung ziehen, ein Grundeinkommen einzuführen, um ihre Inflationsziele zu erreichen.[15]

Kritische Beurteilung

Die Theorie der technologischen Singularität wird von verschiedenen Seiten kritisiert.

Ein Kritikpunkt sind fehlerhafte Datenauslegung und damit mangelnde Wissenschaftlichkeit. Das Mooresche Gesetz werde in die Zukunft extrapoliert, obwohl die bisherige Steigerung der Rechenleistung auf einer Verkleinerung der Computerschaltkreise beruhe, die physikalisch begrenzt sei. Zudem seien die Leistungsangaben lediglich theoretische Höchstwerte, die sich ebenfalls exponentiell von praktischen Werten entfernen, da die Speicherbandbreite viel langsamer wächst (Memory Wall). Das Gehirn speichert Daten nicht separat von Schaltkreisen zu ihrer Verarbeitung. Zwar bilden Perzeptrons (einfache neuronale Netze) den menschlichen Wahrnehmungsprozess mit wenigen Nervenzellen nach. Allerdings steht bereits in verschiedenen Projekten wie dem Human Brain Project die Simulation eines kompletten Gehirns in Aussicht.

Ein Kritikpunkt war die stagnierende Forschung im Gebiet starker KI. Trotz jahrzehntelanger Forschung zeichnete sich lange kein Durchbruch ab.[16] Das wirtschaftliche Interesse am Thema war schon in den 1970er Jahren erloschen und hatte sich der schwachen KI – hochspezialisierten Problemlösern für Einzelaufgaben – zugewandt. Jordan Pollack dämpfte die Erwartungen raschen Fortschritts in dieser Richtung: „Having worked on AI for 30 years, I can say with certainty that Moore’s law doesn’t apply to software design.“[17] Dieser Kritikpunkt ist in den letzten Jahren durch Durchbrüche wie zum Beispiel DeepMinds Sieg im Go gegen Lee Sedol[18] geschwächt worden.

Andere Kritik äußert Zweifel am Singularitätsbegriff. So habe es in der Geschichte der Menschheit viele Zeitpunkte gegeben, zu denen die Welt, in der wir heute leben, völlig unvorstellbar gewesen wäre. Begrenze man die Definition der Singularität auf „überschreitet die Grenze unseres Vorstellungsvermögens“, so sei die angesprochene Singularität nichts Einmaliges, sondern ein immer wieder stattfindendes Ereignis.

Schließlich gibt es Kritik an der Originalität der Theorie. Für den Science-Fiction-Schriftsteller Ken MacLeod etwa ist die Idee der technologischen Singularität nichts weiter als die technisierte Neuauflage des theologischen Begriffs der Lehre von den Hoffnungen auf Vollendung der Welt (der sog. Eschatologie), ähnlich auch bei Jaron Lanier.[19] Verschiedentlich wird die Konzeption der technologischen Singularität als eine technische Variation des Übermenschen eingeordnet.[20] Thomas Wagner sieht sogar den Wunsch nach Gottwerdung des Menschen.[21] So schreibt Kurzweil:

„Wenn wir die gesamte Materie und Energie des Weltalls mit unserer Intelligenz gesättigt haben, wird das Universum erwachen, bewußt werden – und über phantastische Intelligenz verfügen. Das kommt, denke ich, Gott schon ziemlich nahe.“[2]

Organisationen

Das Machine Intelligence Research Institute (MIRI) ist eine gemeinnützige Bildungs- und Forschungsorganisation, die sich der Erforschung und Umsetzung von „freundlicher“ künstlicher Intelligenz (Friendly AI) gewidmet hat. Gegründet wurde diese Institution von Eliezer Yudkowsky, Brian Atkins und Sabine Atkins.

Die Acceleration Studies Foundation (ASF) will die Aufmerksamkeit von Wirtschaft, Wissenschaft und Technik auf den sich beschleunigenden technologischen Fortschritt lenken. Dazu wird alljährlich die an der Stanford University stattfindende Konferenz Accelerating Change abgehalten. Zudem betreibt die Organisation Acceleration Watch[22] eine futurologische Informationswebseite, die aktuelle Entwicklungen im Licht des zunehmenden technologischen Wandels betrachtet.

Das Future of Humanity Institute (FHI) ist ein an der Oxford University angelagertes interdisziplinäres Forschungszentrum mit Schwerpunkt auf der Vorhersage und Vermeidung erheblicher Gefahren für die menschliche Zivilisation. Forschungsgegenstände sind u. a. die Gefahren der künstlichen Intelligenz, das Doomsday-Argument und das Fermi-Paradoxon.

Mitgliederzahl und Forschungsaktivitäten dieser Institute seien laut dem deutschen Soziologen Sascha Dickel „faktisch vernachlässigbar“.[23]

Die dort nicht genannte Singularity University, 2008 von Ray Kurzweil und Peter Diamandis gegründet, ist seit 2013 eine kommerzielle Bildungseinrichtung, Singularity Education Group.

Prominente Vertreter

- Ben Goertzel, Forscher, Autor, Vorsitzender der AGI Society, Gründer von SingularityNet

- Damien Broderick, Literaturwissenschaftler und Schriftsteller

- Hans Moravec, Mathematiker

- John Smart, Philosoph

- Marvin Minsky, Mathematiker

- Nick Bostrom, Philosoph

- Raymond Kurzweil, Informatiker

- Vernor Vinge, Mathematiker und Informatiker

Literatur

- Damien Broderick: The Spike. How Our Lives Are Being Transformed by Rapidly Advancing Technologies. Forge, New York 2001, ISBN 0-312-87781-1.

- Roman Brinzanik, Tobias Hülswitt: Werden wir ewig leben? Gespräche über die Zukunft von Mensch und Technologie. Suhrkamp, 2010, ISBN 978-3-518-26030-2.

- David J. Chalmers: The Singularity: A Philosophical Analysis. In: Journal of Consciousness Studies. Band 17, Nr. 9–10, 2010, S. 7–65 ((online) [PDF; 220 kB; abgerufen am 12. August 2023]).

- Raymond Kurzweil: The Singularity Is Near. When Humans Transcend Biology. Viking, New York 2005, ISBN 0-670-03384-7.

- Vincent C. Müller, Nick Bostrom: Future progress in artificial intelligence: A survey of expert opinion. In: Vincent C. Müller (Hrsg.): Fundamental Issues of Artificial Intelligence (= Synthese Library.). Berlin: Springer, 2016, S. 553–571 (online).

- Anders Sandberg: An overview of models of technological singularity. Tagung „Roadmaps to AGI and the future of AGI.“ Lugano, Schweiz, März 2010 (online).

- Alvin Toffler: Der Zukunftsschock. Strategien für die Welt von morgen. Goldmann, München 1983, ISBN 3-442-11364-4.

- Vernor Vinge: Article. VISION-21 Symposium, März 1993.

- Philipp von Becker: Der neue Glaube an die Unsterblichkeit. Transhumanismus, Biotechnik und digitaler Kapitalismus. Passagen Verlag, Wien 2015, ISBN 978-3-7092-0164-0.

- Thomas Wagner: Robokratie. Google, das Silicon Valley und der Mensch als Auslaufmodell. Papyrossa, Köln 2015, ISBN 978-3-89438-581-1.

Belletristik

- Charles Stross: Accelerando. Heyne, München 2006, ISBN 3-453-52195-1.

Weblinks

- Raymond Kurzweil: Der Mensch, Version 2.0. In: Spektrum der Wissenschaft. Januar 2006.

- Interview mit Robin Hanson. Bei: EconTalk.org. 2. Januar 2011.

- Raymond Kurzweil: Kurzweil Responds: Don’t Underestimate the Singularity. (Seite nicht mehr abrufbar. Suche in Webarchiven) In: TechnologyReview.bom. Oktober 2011.

- BBC-Doku Der Mensch 2.0 – Wenn Computer die Herrschaft übernehmen. (Memento vom 25. November 2012 im Internet Archive). In: Spiegel.TV. 24. Oktober 2006.

Einzelnachweise

- Bernd Vowinkel: Kommt die technologische Singularität? In: hpd.de. Humanistischer Pressedienst, 2. September 2016, abgerufen am 15. Januar 2021.

- Ray Kurzweil: Menschheit 2.0. Die Singularität naht. Berlin 2013, ISBN 978-3-944203-04-1, S. 385.

- Vinge, 1993.

- Detlef Borchers: Ein Achtel Leben: Ray Kurzweil zum 60. Geburtstag. In: heise.de. 12. Februar 2008, abgerufen am 15. Januar 2021.

- Michael Freund: Suche nach der neuen Welt. In: derStandard.at. 10. Februar 2012, abgerufen am 15. Januar 2021.

- Raffael Vötter: RTX 2080 Super, Benchmark-Review. In: pcgameshardware.de. 23. November 2019, abgerufen am 15. Januar 2021.

- Anthony Berglas: Artificial Intelligence Will Kill Our Grandchildren (Singularity). In: Berglas.org. Draft, 2012 (englisch).

- Nick Bostrom: Superintelligenz. Szenarien einer kommenden Revolution. Suhrkamp, Frankfurt am Main. 2016, S. 50 f.

- Stanisław Ulam: Tribute to John von Neumann. In: Bulletin of the American Mathematical Society. 64, Nr. 3, Teil 2, Mai 1958, S. 5 (online).

- Vernor Vinge: Technological Singularity. Department of Mathematical Sciences, San Diego State University, 1993 (online).

- Ray Kurzweil: The Law of Accelerating Returns. Essay, 7. März 2001, abgerufen am 15. Januar 2021.

- Michael Nielsen: Quantum Computing: What It Is, What It Is Not, What We Have Yet to Learn. Vortrag auf dem Singularity Summit. Video, ab 29:11. 5. November 2009, abgerufen am 15. Januar 2021.

- Transcendent Man: What is The Singularity? In: YouTube. Abgerufen am 7. Mai 2021 (englisch).

- Ray Kurzweil claims singularity will happen by 2045. In: Kurzweil. Abgerufen am 6. Mai 2021 (amerikanisches Englisch).

- The ATOM. 26. Februar 2016, abgerufen am 5. September 2023 (amerikanisches Englisch).

- Peter Kassan: A. I. Gone Awry: The Futile Quest for Artificial Intelligence. In: Skeptic.com. Band 12, 2006, abgerufen am 15. Januar 2021.

- Jordan B. Pollack: Seven Questions for the Age of Robots. (PDF; 143 kB). Yale Bioethics Seminar, Januar 2004, abgerufen am 15. Januar 2021.

- Harald Bögeholz: Google AlphaGo schlägt Top-Profi 4:1 im Go. In: c’t. Abgerufen am 15. Januar 2021.

- The Myth Of AI.

- Karen Joisten in: Nietzscheforschung. Band 9, 2002, ISBN 3-05-003709-1, S. 39.

- Thomas Wagner: Der Vormarsch der Robokraten. Silicon Valley und die Selbstabschaffung des Menschen. Blätter für deutsche und internationale Politik, März 2015, S. 113.

- Acceleration Watch (englisch) – Website zum Thema Zukunftsforschung. Abgerufen am 15. Januar 2021.

- Sascha Dickel: Entgrenzung der Machbarkeit? Biopolitische Utopien des Enhancements. In: Peter Böhlemann (Hrsg.): Der machbare Mensch? Lit, Berlin 2010, ISBN 978-3-643-10426-7, S. 75–84, eingeschränkte Vorschau in der Google-Buchsuche, abgerufen am 15. Januar 2021.