Signalentdeckungstheorie

Die Signalentdeckungstheorie ist eine Theorie zur systematischen Untersuchung des sogenannten Response Bias (dt. Reaktionsverzerrung) bei der Detektion schwer zu entdeckender Signale. Dabei ist der Response Bias die Neigung des Signal-Empfängers bei Unsicherheit tendenziell eher zu behaupten ein Signal entdeckt zu haben, oder tendenziell eher zu behaupten ein Signal nicht entdeckt zu haben.

Die Signalentdeckungstheorie zerlegt das Antwortverhalten des Signal-Empfängers in die beiden Komponenten Sensitivität und Antworttendenz:

- Die Sensitivität ist ein Maß dafür, wie gut der Signal-Empfänger tatsächlich zwischen den beiden Zuständen "Signal vorhanden" und "Signal nicht vorhanden" unterscheiden kann.

- Die Antworttendenz ist ein Maß dafür, wie stark der Signal-Empfänger bei Unsicherheit dazu neigt das Vorhandensein eines Signals zu vermuten (und damit "falsche Alarme" zu riskieren)

Die Signalentdeckungstheorie wurde von John A. Swets und David M. Green entwickelt und erstmals 1966 in ihrem Buch Signal Detection Theory and Psychophysics vorgestellt.

Den ersten Anstoß zu dieser Forschung lieferte jedoch bereits im Dezember 1941 der japanische Luftangriff auf Pearl Harbor, der nach offiziellen Angaben weder vom Radar, noch von der Funküberwachung der US-amerikanischen Abwehr entdeckt worden war. Daher stammt auch der Name receiver operator characteristic (s. u.).

Originalexperiment

Green und Swets spielten ihren Probanden viele Geräuschproben vor, die zum Teil nur Rauschen enthielten, zum anderen Teil zusätzlich einen kaum vernehmbaren Ton. Die Versuchspersonen gaben an, ob sie einen Ton gehört haben oder nur Rauschen. Wie schon bei den meisten früheren psychophysischen Experimenten zeigte sich, dass ihre Leistung nicht nur vom Signal-Rausch-Abstand (also wie deutlich der Ton sich vom Rauschen abhob) und ihrer tatsächlichen Detektionsleistung abhing, sondern von vielen zusätzlichen Faktoren beeinflusst wurde, u. a. Motivation, Vigilanz/Müdigkeit, Ablenkung durch Störeinflüsse, Information wie viel Prozent der Geräuschproben Töne enthielt usw. Green und Swets besonderes Interesse galt jedoch der Antworttendenz, die die Probanden zeigten, wenn sie sich unsicher waren: Manche entschieden sich häufiger für „ja, ich habe einen Ton gehört“ (sogenanntes liberales Kriterium), während andere im Zweifelsfall eher „nein, ich habe keinen Ton gehört“ antworteten (konservatives Kriterium). Die tatsächliche Detektionsleistung kann nur ermittelt werden, wenn die Antworttendenz herausgerechnet wird, wie folgendes Beispiel zeigt:

Zwei Medizinstudenten sollen je 20 Röntgenaufnahmen begutachten, von denen, was sie aber nicht wissen, 10 einen Tumor zeigen. Student A möchte möglichst nichts übersehen und entscheidet sich bei 13 Aufnahmen für die Diagnose „Tumor“. Davon sind 9 richtig erkannt und 4 falsch. Student B hingegen möchte sich ganz sicher sein und entscheidet sich bei 7 Aufnahmen für „Tumor“. Davon sind 6 richtig und 1 falsch. Beide haben also die gleiche Anzahl an korrekten Diagnosen (9 – 4 = 6 – 1), nur dass Student A ein liberaleres Antwortkriterium als B und somit eine höhere Anzahl von Fehldiagnosen (= "falscher Alarme") hat.

Maßzahlen

Das Signal kann vorhanden sein oder nicht, und die Testperson (oder das Detektionssystem) kann eine Entdeckung melden oder nicht, sodass vier Kombinationen möglich sind:

| Signal vorhanden | kein Signal vorhanden | |

|---|---|---|

| entdeckt | Treffer (engl. hit) | falscher Alarm (falsch positiv, engl. false alarm) |

| nicht entdeckt | Verpasser (falsch negativ, engl. miss / false rejection) | korrekte Ablehnung (engl. correct rejection) |

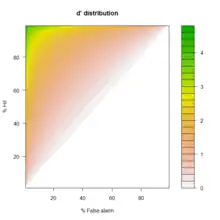

Um das Sensitivitätsmaß d' (englische Aussprache dee prime) zu berechnen, ermittelt man zunächst die relativen Häufigkeiten der Treffer und der falschen Alarme, führt mit diesen Werten eine z-Transformation durch und bildet abschließend die Differenz:

d' = z(Treffer) - z(falscher Alarm)

Eine weitere, seltener verwendete Maßzahl ist die Antworttendenz (auch Reaktionsneigung genannt):

c = −0,5*(z(falscher Alarm) + z(Treffer)).

Beispiel: Ein junger Drogensuchhund hat eine relative Häufigkeit an Treffern von 89 % (Schätzwert für seine Trefferwahrscheinlichkeit 0,89) und eine relative Häufigkeit an falschen Alarmen von 59 % (Schätzwert für seine Fehlalarmwahrscheinlichkeit 0,59). Aus den zugehörigen z-Werten z(0,89) = 1,23 und z(0,59) = 0,23 errechnet sich eine Sensitivität von d' = 1 und eine Antworttendenz von −0,73. Nach einigen Jahren „Berufserfahrung“ hat der Hund eine Trefferquote von 96 % und schlägt nur noch in 39 % der Fälle falschen Alarm. Daher verbessert sich seine Detektionsleistung d' auf 2,03, während seine Antworttendenz c mit −0,74 gleich geblieben ist (was von einem Hund auch zu erwarten ist).

Theoretische Annahmen

Während ursprünglich mit „Rauschen“ tatsächlich das Rauschen im Kopfhörer des „Receiver Operators“ gemeint war, fasst man heute unter diesem Begriff all jene inneren und äußeren Einflüsse zusammen, die den Diagnostiker dazu bewegen können, „ja“ zu sagen, obwohl überhaupt kein Signal vorhanden ist. Die Wahrscheinlichkeit, dass das Rauschen einen Falschalarm hervorruft, wird als normalverteilt angenommen (im Bild die obere Glockenkurve). Gegen dieses Hintergrundrauschen, das immer vorhanden ist, muss sich das Signal „durchsetzen“, d. h., es wird zum Rauschen dazu addiert. Dadurch wird die Wahrscheinlichkeitsverteilung nach rechts verschoben (im Bild die untere Glockenkurve).

Bei schweren Aufgaben (geringer Signal-Rauschen-Abstand) sind die Kurven flach und breit und überlappen stark (so wie hier im Bild), bei leichten Aufgaben sind sie steil und schmal und überlappen nur wenig.

Ob der „Operator“ nun tatsächlich „ja“ sagt, hängt von seinem Antwortkriterium ab. Im Bild liegt die Schwelle eher rechts (mehr „Nein“- als „Ja“-Antworten), er fährt also eine eher konservative Strategie.

Anwendungen

Die Signalentdeckungstheorie kann bei jeder Art von Diagnostik zur Anwendung kommen; einige ihrer Anwendungsfelder sind:

- empirische Wissenschaften (vgl. Fehler 1. Art, Fehler 2. Art)

- Medizin (u. a. Beurteilung von Röntgenbildern, PET- und fMRI-Scans, Labortests usw.)

- Qualitätsmanagement

- Flugsicherung

- Gepäckkontrolle (z. B. in Flughäfen)

- Zutrittskontrolle zu Sportstadien, Diskos usw.

In solch realen Situationen kommt ein weiterer gewichtiger Einfluss auf die Detektionsleistung zum Tragen, nämlich wie groß der Nutzen von Treffern und insbesondere wie gefährlich die Folgen von Verpassern sind.

ROC-Kurve

Eine häufig genutzte grafische Darstellung dieser Maßzahlen ist die Isosensitivitäts- oder ROC-Kurve (ROC: englisch für receiver operating characteristic bzw. deutsch Operationscharakteristik eines Beobachters). Die beiden Medizinstudenten aus obigem Beispiel sind isosensitiv. Dazu wird die relative Häufigkeit der Treffer aufgetragen gegen die relative Häufigkeit der Falschalarme. Alle Diagnostiker mit demselben Detektionsvermögen liegen also auf derselben ROC-Kurve: Wer immer nur rät (hit-Rate = miss-Rate = 0.5, d' = 0) liegt auf einer Geraden der Steigung 1. Gute (mehr Treffer als Falschalarme, d' > 1) und sehr gute Diagnostiker (viel mehr Treffer als Falschalarme, d' > 2) liegen auf mehr oder weniger stark konvex gewölbten Kurven. Die ROC-Kurven sind also von der Antworttendenz c unabhängig. Sollten unsere beiden Medizinstudenten ihre Reaktionsneigung, z. B. durch einen neuen Chef ermuntert, völlig umstellen, würden sie dennoch auf ihrer ROC-Kurve bleiben. Dies lässt sich lediglich durch Training ändern. Auf jeder ROC-Kurve liegen die konservativ Antwortenden (wenige Treffer und wenige Falschalarme) im linken (unteren) Bereich, die liberal Antwortenden (viele Treffer und viele Falschalarme) im rechten (oberen) Bereich.

Literatur

- Swets, J.A. (Hrsg.) (1964) Signal detection and recognition by human observers. New York: Wiley

- Green, D.M., Swets J.A. (1966) Signal Detection Theory and Psychophysics. New York: Wiley, ISBN 0-471-32420-5

- Velden, M. (1982) Die Signalentdeckungstheorie in der Psychologie. Stuttgart: Kohlhammer, ISBN 3-17-004936-4

Weblinks

- interaktives Tutorial (englisch)

- Berechnen und Zeichnen einer ROC-Kurve (englisch)

- Vorlesung von Steven Pinker (englisch)