Median (Stochastik)

Der Median, auch Zentralwert genannt,[1] ist in der Stochastik ein Lagemaß für Wahrscheinlichkeitsverteilungen und Verteilungen von Zufallsvariablen. Somit ist er wie auch der Erwartungswert und der Modus eine Kennzahl dafür, wo sich die „Mitte“ einer Wahrscheinlichkeitsverteilung befindet. Anschaulich ist der Median die Zahl, bei der

- die Wahrscheinlichkeit, einen Wert kleiner oder gleich dem Median zu erhalten, und

- die Wahrscheinlichkeit, einen Wert größer oder gleich dem Median zu erhalten,

gleich ist. Es existieren mehrere Formalisierungen dieser intuitiven Vorstellung, die sich bezüglich der Existenz und Eindeutigkeit des Medians unterscheiden.

In der deskriptiven Statistik wird der Median für Stichproben definiert. Die beiden Begriffe unterscheiden sich insofern, als der eine Kennzahl einer Stichprobe ist (ähnlich dem arithmetischen Mittel), der andere eine Kennzahl einer Wahrscheinlichkeitsverteilung ist (ähnlich dem Erwartungswert). Die beiden sind per se verschieden, lassen sich aber über die empirische Verteilung verknüpfen.

Erste Definition

Für Wahrscheinlichkeitsverteilungen

Gegeben sei eine Wahrscheinlichkeitsverteilung auf , also den reellen Zahlen, versehen mit der Borelschen σ-Algebra.

Dann heißt eine reelle Zahl ein Median (von ), wenn gilt:[2]

- und .

Für Zufallsvariablen

Gegeben sei eine reelle Zufallsvariable .

Dann heißt eine reelle Zahl ein Median (von ), wenn gilt:[2]

- und .

Damit ist der Median der Zufallsvariable genau der Median ihrer Verteilung .

Definition über Verteilungsfunktionen

Ebenso lässt sich der Median auch über Verteilungsfunktionen definieren. Ist die Verteilungsfunktion von oder von , so heißt ein Median (von oder von ), wenn

- und .

Hierbei bezeichnet den linksseitigen Grenzwert.

Bestimmung und Beispiele

Bei stetiger Verteilungsfunktion

Ist die Verteilungsfunktion stetig, so ist genau dann ein Median, wenn eine Lösung der Gleichung

ist.

Dies beruht auf der Tatsache, dass der linksseitige Grenzwert dann mit dem Funktionswert übereinstimmt.

- Beispiele

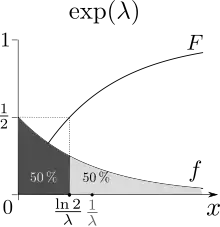

Betrachtet man als Beispiel die Exponentialverteilung, so besitzt diese die Verteilungsfunktion

für einen Parameter . Gleichsetzen mit führt auf die Gleichung

- ,

welche die Lösung

besitzt. In diesem Fall ist der Median eindeutig.

Aber auch bei stetiger Verteilungsfunktion kann der Median mehrdeutig sein. Betrachtet man beispielsweise die Cantor-Verteilung, deren Verteilungsfunktion rechts abgebildet ist, so nimmt diese aufgrund ihrer Konstruktion auf dem gesamten Intervall der Wert an. Jeder Punkt in diesem Intervall ist somit ein Median. Eindeutig ist der Median bei stetiger Verteilungsfunktion beispielsweise dann, wenn die Verteilungsfunktion streng monoton wachsend ist. Spezieller gilt die Eindeutigkeit bereits dann, wenn die Verteilungsfunktion in einer Umgebung, in der sie den Wert annimmt, streng monoton wachsend ist.

Bei Wahrscheinlichkeitsdichten

Besitzt die Zufallsvariable beziehungsweise die Wahrscheinlichkeitsverteilung eine Wahrscheinlichkeitsdichtefunktion (sie ist demnach eine absolutstetige Verteilung), so ist der Median Lösung der Gleichung

- .

Dies folgt direkt aus der Tatsache, dass absolutstetige Verteilungen immer eine stetige Verteilungsfunktion besitzen, diese sich über das Integral bestimmen lässt und der Aussage im obigen Abschnitt.

Mehrere Mediane treten hier beispielsweise auf, wenn die Wahrscheinlichkeitsdichtefunktion auf einem Interval konstant null ist.

- Beispiel

Betrachtet man die Wahrscheinlichkeitsfunktion

- ,

so ist diese im Interval konstant Null. Über die elementaren Integrationsregeln folgt dann, dass jeder Wert in ein Median ist. Das Lösen der Integralgleichung entspricht meist der Bestimmung der entsprechenden Verteilungsfunktion und kann damit als Spezialfall des Vorgehens im oberen Abschnitt angesehen werden.

Eindeutige Definition

Gegeben sei eine Wahrscheinlichkeitsverteilung oder eine reelle Zufallsvariable . Sei die Verteilungsfunktion von bzw. . Dann heißt

der Median von bzw. .[3] Dies entspricht der folgenden Definition: Ist die Quantilfunktion zu , so ist der Median definiert als

- .

Wegen der Rechtsstetigkeit der Verteilungsfunktion kann bei der oberen der beiden Definitionen das Infimum auch durch ein Minimum ersetzt werden.

Eigenschaften

Bei dem Median handelt es sich um ein Quantil, genauer um das 50-%-Quantil.

Ist die Verteilung symmetrisch, gilt also , so ist Null ein Median. Allgemeiner ist bei jeder symmetrischen Verteilung die Symmetrieachse ein Median.

Jeder Median minimiert die absolute Abweichung, sprich ist eine Zufallsvariable mit , so gilt stets

- für alle

und Gleichheit gilt genau dann, wenn auch ein Median ist.

Beziehung zum Median der deskriptiven Statistik

Der Median in der deskriptiven Statistik (als Kennzahl einer Stichprobe) lässt sich über die empirische Verteilung mit dem Median einer Wahrscheinlichkeitsverteilung in Beziehung setzen: Ist eine Stichprobe gegeben, und ist die empirische Verteilung auf so ist ein Median (im Sinne der Wahrscheinlichkeitstheorie) von ein Median (im Sinne der deskriptiven Statistik) von . Aufgrund der verschiedenen Definitionen kann es jedoch auch zu leichten Abweichungen kommen.

Weitere Definitionen

Am direktesten wird der Median als derjenige Wert, für den

gilt, oder als definiert. In beiden Definitionen ist die Existenz des Medians aber nicht garantiert. So ist für

immer , da die Verteilungsfunktion nie den Wert annimmt. Ebenso existiert kein , so dass die obige Gleichungskette erfüllt ist: Für alle ist , ebenso wie für alle immer gilt.

Außerdem ist zu beachten, dass die Verteilungsfunktionen in älterer russischsprachiger Literatur als linksstetig und nicht wie im deutschen Sprachraum als rechtsstetig definiert werden. So ist dann zum Beispiel im Falle des fairen Münzwurfes einmal anstelle von .

Weblinks

- Median (in Statistics). In: Michiel Hazewinkel (Hrsg.): Encyclopedia of Mathematics. Springer-Verlag und EMS Press, Berlin 2002, ISBN 1-55608-010-7 (englisch, encyclopediaofmath.org).

- V.V. Senatov: Quantile. In: Michiel Hazewinkel (Hrsg.): Encyclopedia of Mathematics. Springer-Verlag und EMS Press, Berlin 2002, ISBN 1-55608-010-7 (englisch, encyclopediaofmath.org).

- Eric W. Weisstein: Statistical Median. In: MathWorld (englisch).

Literatur

- Christian Hesse: Angewandte Wahrscheinlichkeitstheorie. 1. Auflage. Vieweg, Wiesbaden 2003, ISBN 3-528-03183-2, doi:10.1007/978-3-663-01244-3.

- Norbert Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. Eine Einführung. 2., überarbeitete und erweiterte Auflage. Springer-Verlag, Berlin Heidelberg 2014, ISBN 978-3-642-45386-1, doi:10.1007/978-3-642-45387-8.

Einzelnachweise

- Hans-Otto Georgii: Stochastik. Einführung in die Wahrscheinlichkeitstheorie und Statistik. 4. Auflage. Walter de Gruyter, Berlin 2009, ISBN 978-3-11-021526-7, S. 101, doi:10.1515/9783110215274.

- Hans-Otto Georgii: Stochastik. Einführung in die Wahrscheinlichkeitstheorie und Statistik. 4. Auflage. Walter de Gruyter, Berlin 2009, ISBN 978-3-11-021526-7, S. 233, doi:10.1515/9783110215274.

- Norbert Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. Eine Einführung. 2., überarbeitete und erweiterte Auflage. Springer-Verlag, Berlin Heidelberg 2014, ISBN 978-3-642-45386-1, S. 113, doi:10.1007/978-3-642-45387-8.