Süni intellekt təhlükəsizliyi

Süni intellekt təhlükəsizliyi — süni intellekt (Sİ) sistemləri nəticəsində yarana biləcək qəzaların, sui-istifadənin və ya digər zərərli nəticələrin qarşısının alınması ilə əlaqəli fənlərarası sahə. O, süni intellekt sistemlərini əxlaqlı və faydalı etmək məqsədi daşıyan maşın etikasını və süni intellektin uyğunlaşdırılmasını, süni intellekt təhlükəsizliyi isə risklərin monitorinqi sistemləri və onların daha etibarlı vəziyyətə gətirilməsi də daxil olmaqla texniki problemləri əhatə edir. Süni intellektlə bağlı araşdırmalardan əlavə, bu, təhlükəsizliyi təşviq edən norma və siyasətlərin işlənib hazırlanmasını da nəzərdə tutur.

| Süni intellekt |

|---|

|

|

Yanaşmalar

|

|

|

|

Texnologiya

|

|

Lüğət

|

Motivasiyalar

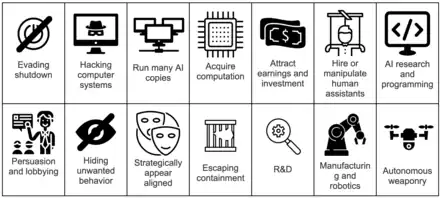

Süni intellekt tədqiqatçılarının süni intellekt texnologiyasının yaratdığı riskin şiddəti və əsas mənbələri haqqında çox fərqli fikirləri var,[3][4][5] baxmayaraq ki, sorğular ekspertlərin yüksək nəticəli riskləri ciddi qəbul etdiyini göstərir. Süni intellekt tədqiqatçılarının iki sorğusunda, iştirakçılar ortaq fikir olaraq ümumilikdə süni intellektə nikbin baxıb, lakin qabaqcıl süni intellektin "çox pis (məsələn, bəşəriyyətin məhvi)" nəticəsinə 5% ehtimal verib.[3] 2022-ci ildə "Natural Language Processing" (NLP) icmasının sorğusunda iştirakçıların 37%-i süni intellektlə bağlı qərarların "ən azı nüvə müharibəsi qədər pis" fəlakətə səbəb ola biləcəyi fikri ilə tam və qismən razılaşıb.[6] Alimlər kritik sistem uğursuzluqları,[7] qərəzlilik[8] və süni intellektlə işləyən müşahidədən yaranan cari riskləri,[9] texnoloji işsizlikdən, rəqəmsal manipulyasiyadan[10] və silahlaşdırmadan[11] yaranan riskləri və gələcək süni ümumi intellekt (SÜİ) agentlərinə nəzarəti itirməkdən yaranan spekulyativ riskləri müzakirə edirlər.[12]

Bəziləri, 2015-ci ildə onları "Marsa hələ ayaq basmamış əhalinin aşırı çoxluğundan narahat olmaq" ilə müqayisə edən Endryu In kimi SÜİ ilə bağlı narahatlıqları tənqid etdi.[13] Digər tərəfdən Stüart Rassel, "insan ixtirasını az qiymətləndirməkdənsə, onu təxmin etmək daha yaxşıdır" deyərək ehtiyatlı olmağa çağırır.[14]

İstinadlar

- Carlsmith, Joseph. "Is Power-Seeking AI an Existential Risk?". 2022-06-16. arXiv:2206.13353 [cs.CY].

- "'The Godfather of A.I.' warns of 'nightmare scenario' where artificial intelligence begins to seek power". Fortune (ingilis). 2023-05-25 tarixində arxivləşdirilib. İstifadə tarixi: 2023-06-10.

- Grace, Katja; Salvatier, John; Dafoe, Allan; Zhang, Baobao; Evans, Owain. "Viewpoint: When Will AI Exceed Human Performance? Evidence from AI Experts". Journal of Artificial Intelligence Research. 62. 2018-07-31: 729–754. doi:10.1613/jair.1.11222. ISSN 1076-9757. 2023-02-10 tarixində arxivləşdirilib. İstifadə tarixi: 2022-11-28.

- Zhang, Baobao; Anderljung, Markus; Kahn, Lauren; Dreksler, Noemi; Horowitz, Michael C.; Dafoe, Allan. "Ethics and Governance of Artificial Intelligence: Evidence from a Survey of Machine Learning Researchers". Journal of Artificial Intelligence Research. 71. 2021-05-05. arXiv:2105.02117. doi:10.1613/jair.1.12895.

- Stein-Perlman, Zach; Weinstein-Raun, Benjamin; Grace. "2022 Expert Survey on Progress in AI". AI Impacts. 2022-08-04. 2022-11-23 tarixində arxivləşdirilib. İstifadə tarixi: 2022-11-23.

- Michael, Julian; Holtzman, Ari; Parrish, Alicia; Mueller, Aaron; Wang, Alex; Chen, Angelica; Madaan, Divyam; Nangia, Nikita; Pang, Richard Yuanzhe; Phang, Jason; Bowman, Samuel R. "What Do NLP Researchers Believe? Results of the NLP Community Metasurvey". Association for Computational Linguistics. 2022-08-26. arXiv:2208.12852.

- De-Arteaga, Maria. Machine Learning in High-Stakes Settings: Risks and Opportunities (PhD). Carnegie Mellon University. 2020-05-13.

- Mehrabi, Ninareh; Morstatter, Fred; Saxena, Nripsuta; Lerman, Kristina; Galstyan, Aram. "A Survey on Bias and Fairness in Machine Learning". ACM Computing Surveys (ingilis). 54 (6). 2021: 1–35. arXiv:1908.09635. doi:10.1145/3457607. ISSN 0360-0300. 2022-11-23 tarixində arxivləşdirilib. İstifadə tarixi: 2022-11-28.

- Feldstein, Steven. The Global Expansion of AI Surveillance (Hesabat). Carnegie Endowment for International Peace. 2019.

- Barnes, Beth. "Risks from AI persuasion". Lesswrong. 2021. 2022-11-23 tarixində arxivləşdirilib. İstifadə tarixi: 2022-11-23.

- Brundage, Miles; Avin, Shahar; Clark, Jack; Toner, Helen; Eckersley, Peter; Garfinkel, Ben; Dafoe, Allan; Scharre, Paul; Zeitzoff, Thomas; Filar, Bobby; Anderson, Hyrum; Roff, Heather; Allen, Gregory C; Steinhardt, Jacob; Flynn, Carrick. "The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation". Apollo-University Of Cambridge Repository, Apollo-University Of Cambridge Repository. Apollo - University of Cambridge Repository. 2018-04-30. doi:10.17863/cam.22520. 2022-11-23 tarixində arxivləşdirilib. İstifadə tarixi: 2022-11-28.

- Carlsmith, Joseph. "Is Power-Seeking AI an Existential Risk?". 2022-06-16. arXiv:2206.13353.

- "AGI Expert Peter Voss Says AI Alignment Problem is Bogus | NextBigFuture.com" (ingilis). 2023-04-04. 2023-07-15 tarixində arxivləşdirilib. İstifadə tarixi: 2023-07-23.

- Dafoe, Allan. "Yes, We Are Worried About the Existential Risk of Artificial Intelligence". MIT Technology Review. 2016. 2022-11-28 tarixində arxivləşdirilib. İstifadə tarixi: 2022-11-28.