Deepfake

Deepfake (ing. portmanteau of "deep learning" and "fake") — süni intellekt neyron şəbəkələrindən istifadə edərək yaradılan foto, audio və video materialların, səsin sintezi üçün texnologiyadır.[1][2] İlk dəfə 2017-ci ildə Amerikan sosial mediası olan Reddit-də bəzi məşhurların yer aldığı, lakin özlərinə aid olmayan videolar yayımlandı.Bu texnologiyadan istifadə edən proqramlar 2 süni intellekt sistemindən ibarətdir. Bu sistemlərdən birincisi saxta görüntüsü hazırlanacaq şəxsin bir çox şəklini skan edir və digər tərəfə kopyalayır. İkinci süni intellekt hissəsi isə hər iki görüntünü qarşılaşdıraraq aralarındakı bənzərlik faizini hesablayır. Bənzətmədiklərini yenidən skan edir və hazırlaya biləcəyi ən yaxşı versiyaya qədər bu proses davam edir. Ukrayna müharibəsinin gedişinə təsir edəcək video da məhz "Deepfake" proqramı vasitəsilə hazırlanıb. Prezident Volodimir Zelenskinin adından Ukrayna hərbçilərinə "təslim olun" çağırışı edilib. Sonradan videonun saxta olduğu və Rusiya tərəfindən hazırlandığı üzə çıxıb. Mütəxəssislərin fikrincə, gələcəkdə insanın sadəcə üzünün deyil, onun hərəkətlərinin, digər bədən üzvlərinin də oxşadılması süni intellekt vasitəsilə mümkün olacaq. Ona görə də, bəzi dövlətlər bu proqramların yaratdığı təhlükənin qarşısını almaq üçün müəyyən addımlar atır. ABŞ-ın bəzi ştatlarında (Virciniya və Kaliforniya) "Deepfake"dən qanunsuz istifadəyə görə, 1 ilə qədər həbs cəzası verilir.

| Deepfake | |

|---|---|

Deepfake süni intellekt neyron şəbəkələrindən istifadə edərək yaradılan foto | |

| Sayt | deepfakesweb.com |

Audio Deepfake

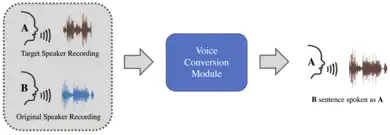

Mətndən nitq alqoritmdən və insanın real nitqinin audio yazılarının kompüterdə istifadə etməklə həmin şəxsin səsini “saxta” etmək mümkündür. Audio deepfake belə yaradılır. Bu texnologiyadan istifadə etməklə filmləri lokallaşdırarkən aktyorların səsini uyğunlaşdırmaq, nitq qabiliyyətini itirmiş insanlar üçün təbii nitq yaratmaq, valideynlərin səsində uşaqlar üçün audio kitablar oxumaq, nitqi müəyyən vurğuya uyğunlaşdırmaq, real video avatarlar, səsli köməkçilər yaratmaq mümkündür. Bu texnologiya ilə şəxsləri aldatmaq, gözdən salmaq və ya yanlış məlumat vermək üçün də istifadə edilə bilər.

Deepfake rəqəmsal dövrün böyük təhlükəsi

Deepfake süni intellektə əsaslandığı üçün qabaqcıl texnologiyadır. Hədəf edilən şəxsin bütün hərəkətlərini, mimikalarını və üz cizgilərini ən incə detalına qədər araşdıra bilir və danışıq tərzini öyrənir. Bu, yaradılmış nüsxəni müvafiq xüsusiyyətlərə malik şəxsin üzərinə yerləşdirməyi asanlaşdırır. Yəni hədəfə çevrilən insanın daha əvvəl heç olmadığı bir mühitdə olduğu göstərilə bilər. O, yersiz açıqlamalar verdiyi üçün şübhə altına düşə bilər və bir çox qruplar və şəxslər tərəfindən hədəfə alına bilər. Bu, çaşqınlıqlara, anlaşılmazlıqlara və hətta hüquqi cəzalara səbəb ola bilər. Xüsusilə tanınan insanlar bu texnologiyaya görə ictimaiyyət tərəfindən kənarlaşdırıla və ya sosial təzyiqə məruz qala bilərlər. Süni intellekte əsaslanan Deepfake texnologiyasının film sektorunda işləri asanlaşdıracağı gözlənilsə də, reallığa çox bənzəyən saxta videolar hazırlaması işləri qəlizləşdirdi. "Deepfake" texnologiyası fotodan reallığa yaxın, danışan, gülən qeyri-real videolar hazırlamağa imkan yaradır. Həmçinin, bir videodakı danışığı tamamilə dəyişə bilir. Film, televiziya sektorunda əhəmiyyətli olsa da, pis məqsədlə istifadə oluna biləcəyini nəzərə alsaq, risk daşıyır.[3]

Maliyyə fırıldaqçılığı

Cinayətkarlar qurbanları öz tələlərinə salmaq üçün məşhurları təqlid etmək üçün yaradılmış şəkillərdən istifadə edərək sosial mühəndislik texnikalarından istifadə edirlər. Məsələn, İlon Maskın şübhəli kriptovalyuta investisiya sxemindən yüksək gəlirlər vəd edən deepfake videosu sürətlə yayılaraq istifadəçilərin pul itirməsinə səbəb oldu. Fırıldaqçılar bu kimi saxta videolar yaratmaq üçün məşhurların şəkillərindən istifadə edir, köhnə videoları birləşdirir və sosial media platformalarında canlı yayımlar açır və onlara göndərilən kriptovalyuta ödənişlərini ikiqat artıracağını vəd edir.

Biznes riskləri

Çox vaxt deepfake ilə şirkət rəhbərlərini şantaj və sənaye casusluğu kimi cinayətlər üçün bizneslərini hədəfə almaqda istifadə olunur. Məsələn, kibercinayətkarlar səsli deepfake istifadə edərək BƏƏ-də bank menecerini aldadaraq 35 milyon dollar oğurlamağı bacarıblar. inandırıcı deepfake yaratmaq üçün onun rəhbərinin səsinin kiçik bir qeydindən istifadə olunub. Deepfake ilə kriptovalyuta platforması Binance-ı aldatmağa cəhd edilib.

Deepfake pornoqrafiya

Deepfake-in təhlükəli tərəflərindən biri də fərdin məxfiliyini pozulmasıdır. Deepfake videolar bir insanın üzünü pornoqrafik videonun üzərinə qoyaraq, böyük zərər və sıxıntıya səbəb ola bilər. İnternetdə açıq-saçıq səhnələrdə bəzi məşhurların üzlərini pornoqrafik aktyorların üz cizgiləri ilə montaj olunduğu faktlar çoxdu. Nəticədə belə hallarda hədəf şəxslərin reputasiyası zədələnir və hüquqları pozulur.

İstinadlar

- "Deepfake (saxta foto, video və audio məlumatlar) nədir?". 2023-08-13 tarixində arxivləşdirilib. İstifadə tarixi: 2023-08-13.

- "Deepfake Nədir?". 2023-08-19 tarixində arxivləşdirilib. İstifadə tarixi: 2023-08-19.

- "Rəqəmsal dövrün böyük təhlükəsi: "Deepfake!"". 2023-08-13 tarixində arxivləşdirilib. İstifadə tarixi: 2023-08-13.