الشبكات العصبية المتكررة

الشبكات العصبية المتكررة أو شبكات ردود الفعل العصبية (بالإنكليزية: Recurrent neural network) التي هي على النقيض من شبكات feedforward، وأهم ما تتميزبه هو أن الاتصالات بين الخلايا العصبية تكون في طبقة واحدة والخلايا العصبية في نفس أو الطبقة السابقة. في الدماغ ، هذه هي الطريقة الأفضل لربط الشبكات العصبية ، خاصة في القشرة المخية الحديثة . في الشبكات العصبية الاصطناعية ، يتم استخدام الترابط المتكرر للخلايا العصبية النموذجية لاكتشاف المعلومات ذات الترميز الزمني في البيانات.[1] ومن الأمثلة على هذه الشبكات العصبية المتكررة Hopfield العصبية المترابطة تمامًا.

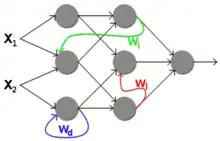

يمكن تقسيم الشبكات المتكررة على النحو التالي:

- مع ردود فعل مباشرة (بالإنجليزية: direct feedback) يتم استخدام الإخراج الخاص من الخلايا العصبية كمدخل إضافي.

- ردود الفعل غير المباشرة (بالإنجليزية: indirect feedback) يربط إخراج الخلايا العصبية مع الخلايا العصبية من الطبقات السابقة.

- ردود الفعل الجانبية (بالإنجليزية: lateral feedback) يربط ناتج الخلايا العصبية بخلايا عصبية أخرى في نفس الطبقة.

- من خلال الاتصال الكامل ، يكون لكل ناتج من الخلايا العصبية اتصال مع كل خلية عصبية أخرى.

تُستخدم الشبكات العصبية المتكررة في الممارسة العملية للمشكلات التي تتطلب معالجة التسلسلات. تشمل الأمثلة التعرف على خط اليد والتعرف على الكلام والترجمة الآلية . النوع السائد من الشبكات العصبية المتكررة هنا هو LSTMs أو المتغيرات المماثلة التي تعتمد على التغذية الراجعة المباشرة.

يمكن برمجة وتنفيذ الشبكات العصبية المتكررة في مكتبات البرامج الشائعة مثل PyTorch بسهولة في Python ثم ترجمتها إلى كود فعال باستخدام التجميع في الوقت المناسب.

تدريب الشبكات العصبية المتكررة

ليس من السهولة تدريب الشبكات العصبية الاصطناعية المتكررة باستخدام أساليب التعلم الآلي. [2] لذلك فإن الأسلوب الشائع ليس تدريب الشبكة ، بل تدريب الشبكة على قراءتها. يُنظر إلى الشبكة العصبية المتكررة على أنها ما يسمى بخزان في سياق حوسبة الخزان. في حالة LSTMs ، يتم تحويل الشبكات إلى شبكة تغذية وفقًا لطول التسلسل باستخدام الانتشار العكسي عبر الوقت (انظر backpropagation) أثناء عملية التدريب. [3] هذا يجعل تعقيد سلوك التعلم مشابهًا لسلوك شبكات التغذية التقليدية.

نقطة البداية للانتشار العكسي عبر الزمن هي أن دالة الخسارة الكلية للسلسلة الزمنية تتكون من خطوات الوقت والتي يمكن تمثيلها على النحو التالي:

- و

بواسطة هي وظيفة ناتجة عن الشبكة (في الموعد ) بهدف يقارن وأين هو متجه المعلمة الثابتة للوقت للشبكة العصبية المتكررة. يسمح الانتشار العكسي عبر الزمن بحساب المشتق الكلي (من حيث المكون) من خلال تطبيق قاعدة السلسلة . منذ الإخراج حتى من القيم من الخطوة الزمنية السابقة يعتمد وهذا على ، يجب تضمين هذه الخطوات الزمنية السابقة في الاشتقاق.

يمكن أن تنشأ مشاكل في تدريب الشبكات العصبية المتكررة بسبب اختفاء التدرجات أو انفجارها. يمكن استخدام إجبار المعلم (بالإنكليزية:Teacher-Forcing) للتحايل على هذه المشكلات ، ولكن يتم إدخال مقايضة التعرض للانحياز (بالإنكليزية: Bias-Exposure tradeoff ).[4]

المؤلفات

- أندرياس زيل: محاكاة الشبكات العصبية. تم العثور على R. Oldenbourg Verlag ، ميونيخ 1997 ، ISBN 3-486-24350-0 .

مراجع

- Computational Intelligence: Eine methodische Einführung in Künstliche Neuronale Netze, Evolutionäre Algorithmen, Fuzzy-Systeme und Bayes-Netze (ط. Zweite Auflage). Wiesbaden: Springer-Vieweg. 2015. ص. 515. ISBN:978-3-658-10903-5.

- "Reservoir Computing". Reservoir Lab Ghent. 30 مايو 2008. مؤرشف من الأصل في 2010-04-05. اطلع عليه بتاريخ 2010-04-02. "نسخة مؤرشفة". مؤرشف من الأصل في 2010-04-05. اطلع عليه بتاريخ 2021-12-28.

- "A Beginner's Guide to Recurrent Networks and LSTMs - Deeplearning4j: Open-source, distributed deep learning for the JVM". اطلع عليه بتاريخ 2016-07-16. "نسخة مؤرشفة". مؤرشف من الأصل في 2016-07-16. اطلع عليه بتاريخ 2021-12-28.

- Quantifying Exposure Bias for Open-ended Language Generation https://arxiv.org/abs/1905.10617#:~:text=The%20exposure%20bias%20problem%20refers,network%20language%20models%20(LM). نسخة محفوظة 2021-10-07 على موقع واي باك مشين.

- بوابة علم الحاسوب